人工智能技术的快速发展催生了多种模型类型,其中大模型与小模型的应用场景和技术路径存在显著差异,理解二者的区别与适用性,对开发者、企业决策者及技术爱好者均具有现实意义。

大模型与小模型的定义与特点

大模型通常指参数量超过百亿的深度学习模型,例如GPT-4、PaLM等,其核心优势在于通过海量数据训练获得泛化能力,能够处理复杂任务如自然语言生成、多模态内容理解,小模型则参数量较小,通常在百万至千万级别,典型代表包括MobileNet、TinyBERT等,特点是轻量化、推理速度快,适合部署在资源受限的设备中。

大模型的训练依赖高性能计算集群,需要数千块GPU协同工作,且数据规模常达到TB级别,小模型则可通过单台服务器完成训练,数据量级显著降低,Meta发布的Llama 2-7B模型参数规模虽属于“中等”,但在实际应用中仍需要优化才能适配移动端。

开发流程的关键差异

-

数据准备阶段

大模型对数据质量和多样性要求极高,以ChatGPT为例,其训练数据覆盖书籍、网页、学术论文等多种来源,并通过清洗、去重、标注等步骤构建高质量语料库,小模型的数据需求更聚焦,例如工业质检场景中,可能仅需数万张特定缺陷图片即可完成训练。 -

模型架构设计

大模型普遍采用Transformer结构,通过增加注意力机制层数提升性能,谷歌的PaLM模型使用Pathways架构,将模型拆分为多个专家模块,动态分配计算资源,小模型则注重压缩技术,如知识蒸馏(将大模型能力迁移至小模型)、量化(降低参数精度)、剪枝(移除冗余神经元)等,华为的TinyBERT通过分层蒸馏,将BERT模型压缩至1/7大小且保持90%性能。

-

训练与调优策略

大模型训练需解决分布式计算难题,OpenAI采用3D并行策略(数据并行、流水线并行、模型并行),同时使用混合精度训练减少显存占用,小模型的调优重点在于防止过拟合,常用方法包括数据增强、正则化约束、早停机制等。

应用场景的适配原则

选择模型类型的核心标准是场景需求与资源限制的平衡。

- 大模型的适用场景

- 需要处理开放域问题的场景:如智能客服需理解用户自由提问

- 多任务协同需求:自动驾驶系统需同时处理图像识别、路径规划、语音交互

- 研究性质项目:探索模型能力边界,如蛋白质结构预测

- 小模型的优势领域

- 边缘计算设备:智能手机、物联网传感器等内存有限的环境

- 实时性要求高的场景:工业流水线检测需毫秒级响应

- 成本敏感型业务:中小企业部署本地化AI服务

某医疗影像公司曾尝试用GPT-3处理CT报告生成,发现推理延迟达3秒/次且硬件成本过高,改用定制化小模型后,响应时间缩短至0.2秒,年运维成本降低76%。

技术演进趋势观察

当前行业呈现两种并行趋势:头部机构仍在探索更大规模模型,如谷歌正在研发参数超万亿的模型;模型轻量化技术快速发展,2023年国际机器学习会议(ICML)有17篇论文聚焦小模型优化。

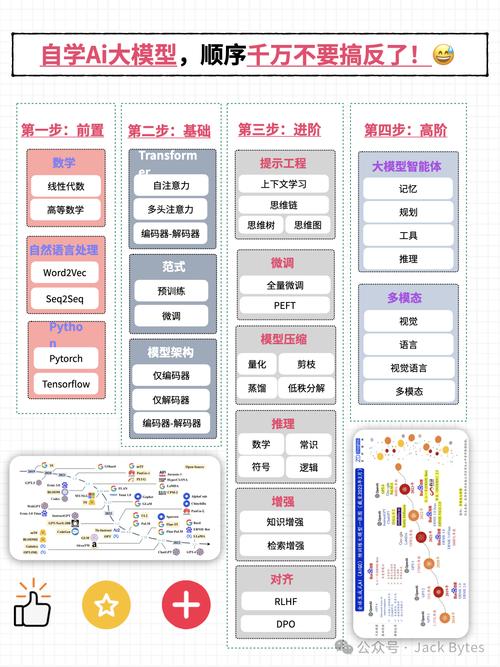

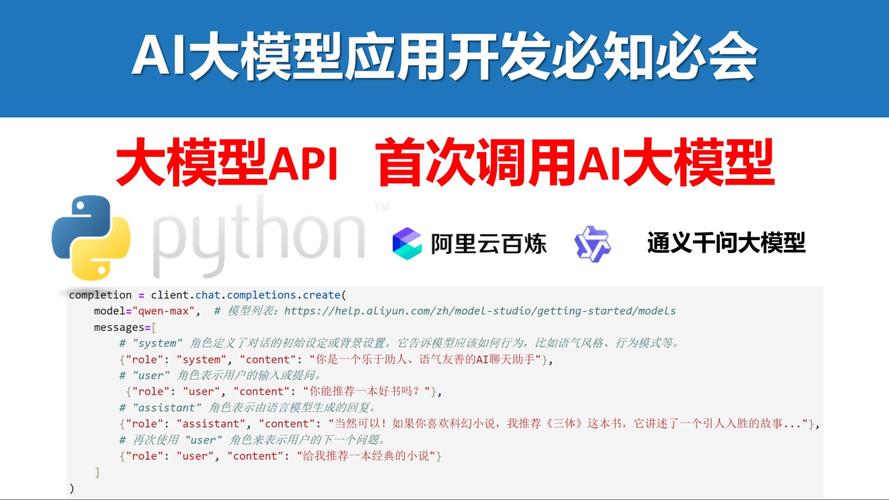

值得关注的是“预训练+微调”模式正在普及,开发者可基于开源大模型(如LLaMA),使用垂直领域数据进行微调,再通过量化工具导出适配业务的轻量版本,这种模式在金融、法律等专业领域已有成功案例。

个人认为,盲目追求模型规模的时代正在终结,2024年之后,更多企业会转向“适度规模+精准优化”的技术路线,就像汽车工业从追求排量转向能效比,AI行业也将更关注单位算力创造的价值,真正解决问题的不是参数数量,而是技术与场景的契合度。