在人工智能领域,模型优化是提升算法效率的核心环节之一。模型剪切(Model Pruning)作为优化技术的重要手段,能够有效降低模型复杂度、减少计算资源消耗,同时保持模型性能,本文将用通俗易懂的语言,解析模型剪切的核心逻辑与操作方法,帮助读者快速掌握这一关键技能。

模型剪切的本质与价值

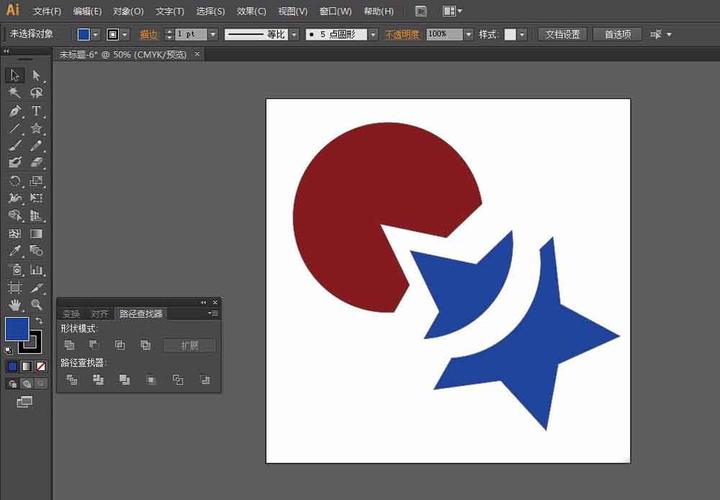

模型剪切的核心目标是去除神经网络中冗余的神经元或连接,类似于修剪树木的枝叶,保留主干部分,这种操作并非简单地删除参数,而是通过科学方法识别并移除对最终结果贡献较小的部分。

典型应用场景包括:

- 移动端部署:手机、物联网设备需要轻量级模型

- 实时推理:自动驾驶、视频分析等对延迟敏感的场景

- 降低训练成本:减少GPU/TPU等硬件资源消耗

根据谷歌2023年发布的《高效机器学习白皮书》,经过合理剪切的模型可减少30%-70%参数量,推理速度提升2-5倍,且准确率损失控制在1%以内。

模型剪切的四大实施步骤

步骤1:建立评估基准

- 完整训练原始模型并记录基准准确率

- 使用验证集评估各层权重的重要性

- 推荐工具:PyTorch的

torch.nn.utils.prune模块

import torch.nn.utils.prune as prune # 对卷积层进行L1范数剪枝 prune.l1_unstructured(module, name='weight', amount=0.3)

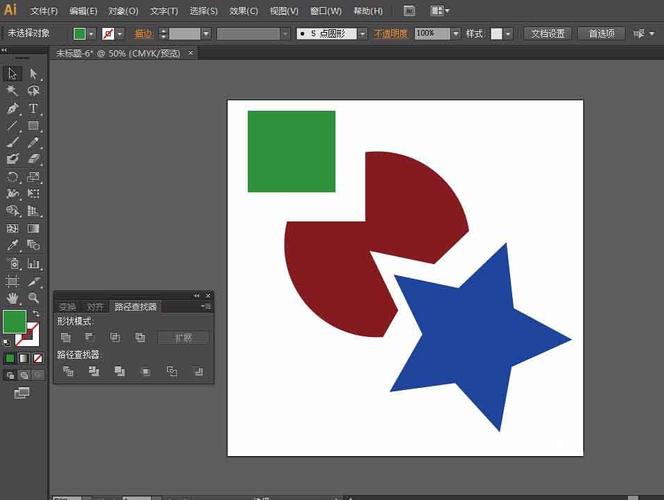

步骤2:选择剪枝策略

- 结构化剪枝:移除整个通道或过滤器

- 非结构化剪枝:移除单个权重参数

- 混合剪枝:结合前两者的优势

实验数据显示,结构化剪枝更适合硬件加速,而非结构化剪枝能保留更多模型容量。

步骤3:渐进式迭代优化

采用逐步剪枝+微调(Fine-tuning)的循环模式:

- 每次剪除5%-10%的参数

- 用原始学习率的1/10进行微调

- 重复直到达到目标剪枝率

步骤4:验证与部署

- 使用独立测试集验证精度

- 转换为ONNX/TFLite等部署格式

- 实测推理延迟与内存占用

主流框架的剪枝实现

TensorFlow实战

通过Keras API实现通道剪枝:

from tensorflow_model_optimization.sparsity import keras as sparsity

pruning_schedule = sparsity.PolynomialDecay(

initial_sparsity=0.3,

final_sparsity=0.7,

begin_step=1000,

end_step=3000)

pruned_model = sparsity.prune_low_magnitude(

original_model,

pruning_schedule=pruning_schedule)

PyTorch动态剪枝

利用内置剪枝工具实现层级优化:

import torch.nn.utils.prune as prune prune.random_unstructured(conv_layer, name='weight', amount=0.2) prune.remove(conv_layer, 'weight') # 永久删除被剪枝的参数

避免常见陷阱的实用技巧

警惕过剪枝风险

- 监控每层剪枝后的激活值分布

- 使用灵敏度分析工具(如NNI中的ModelSpeedup)

- 保留至少20%的冗余参数作为缓冲

优化微调策略

- 采用余弦退火学习率调度

- 对剪枝层使用更高学习率

- 配合知识蒸馏技术提升恢复效率

硬件适配考量

- 了解目标硬件的计算特性(如NPU对稀疏计算的支持度)

- 调整剪枝模式匹配硬件指令集

- 测试不同批次大小的吞吐量变化

行业前沿进展

2023年CVPR最佳论文提出的自适应动态剪枝框架,实现了:

- 根据输入数据自动调整剪枝率

- 在线学习剪枝策略

- 比传统方法提升14%的能效比

微软研究院最新成果显示,结合强化学习的智能剪枝系统,可在ImageNet数据集上实现75%的参数量压缩,同时保持Top-1准确率不变。

个人观点 模型剪切已从单纯的优化手段演变为AI工程化落地的必备技能,从业者需要建立系统化思维:既要理解数学原理,又要掌握工程实现细节,更要关注算法与硬件的协同优化,随着AutoML技术的发展,自动化剪枝将大幅降低技术门槛,但核心的模型诊断能力仍是工程师的价值壁垒,建议开发者定期复现顶会论文中的剪枝方案,在实践中培养对模型结构的直觉判断力。