从零开始构建AI声音模型的技术路径

声音模型的训练已成为人工智能领域的热门研究方向,无论是语音合成、音色转换,还是音频修复,训练一个高质量的AI声音模型需要系统性规划与严谨的技术执行,本文将从技术原理、数据准备、训练流程到实际应用,完整解析声音模型构建的核心要点。

理解声音模型的本质

声音模型的核心任务是学习声音信号的特征规律,与图像或文本不同,声音数据具有时序性、连续性和高维特性,需通过声学建模捕捉音高、音色、节奏等参数,目前主流模型分为两类:

- 声码器(Vocoder):将频谱图转换为波形,如WaveNet、HiFi-GAN;

- 端到端模型:直接生成音频,如Tacotron、VITS。

模型选择需权衡目标场景,语音合成需要高自然度,可选用基于Transformer的FastSpeech;音色克隆则依赖少量样本适配的Few-shot模型。

数据采集与预处理

数据质量直接决定模型上限。

数据收集原则

- 纯净度:录音环境需低噪声,采样率不低于16kHz;

- 多样性:覆盖不同场景、情感和发音习惯;

- 合规性:确保数据版权与隐私授权。

专业团队常采用多麦克风阵列录制,并通过声学检测工具(如Praat)筛选异常音频。

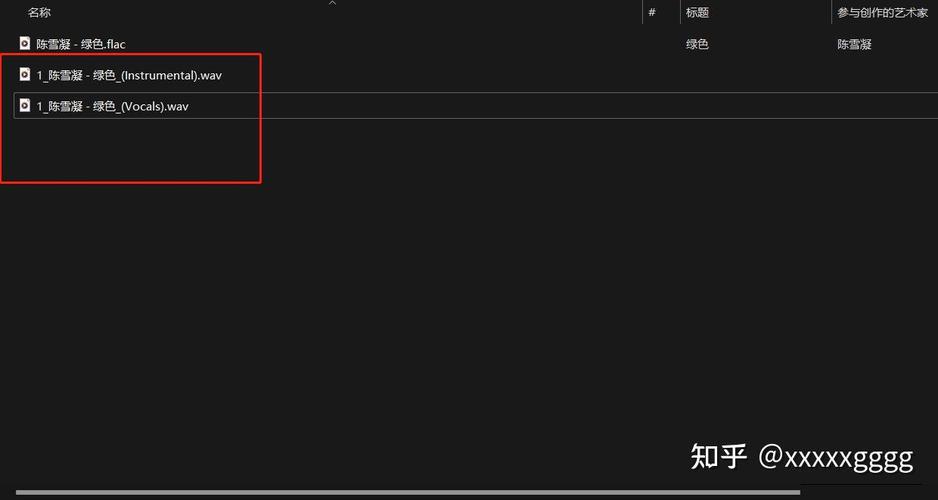

预处理流程

- 标准化:统一音频格式(WAV)、采样率和声道;

- 降噪:使用RNNoise或Spectral Gate算法消除背景杂音;

- 标注:对齐文本与语音(强制对齐工具如MFA),标注音素边界;

- 特征提取:转换为梅尔频谱图或F0基频参数。

模型架构设计与训练

框架选择

- PyTorch:灵活性强,适合自定义模型;

- TensorFlow:工业部署成熟,支持TPU加速。

推荐使用开源项目(如ESPnet、Fairseq)快速搭建基线模型。

关键训练技巧

- 损失函数优化:结合L1损失(保真度)与对抗损失(自然度);

- 学习率调度:采用Warmup策略避免早期震荡;

- 数据增强:添加混响、变速变调提升泛化性;

- 多任务学习:联合训练音高预测与时长模型。

硬件配置

- GPU:至少16GB显存(如NVIDIA V100);

- 分布式训练:多卡并行时需调整批次大小与梯度累积步数。

模型评估与调优

客观指标

- MOS(平均意见分):人工评分音频自然度(1-5分);

- MCD(梅尔倒谱失真):量化频谱差异;

- RTF(实时因子):评估推理速度(目标值<0.1)。

常见问题与对策

- 金属音:检查声码器过拟合,增加频谱平滑约束;

- 断句不自然:调整语言模型的注意力机制;

- 音色失真:补充目标说话人的训练数据。

落地应用的挑战

- 计算资源:实时推理需模型轻量化(知识蒸馏或量化);

- 伦理风险:部署声音克隆功能时,需加入水印与身份验证;

- 多语言适配:跨语种训练需解决音素集差异(如中文与英语的声调映射)。

个人观点

当前声音模型的瓶颈已从技术实现转向数据与场景的精细化匹配,未来的突破点可能在于小样本学习与跨模态融合——结合唇形视频或文本情感标签生成更具表现力的语音,开发者需警惕技术滥用,在创新与伦理之间找到平衡点。