用大白话拆解AI大模型:它究竟懂什么?

想象一下,你训练了一只记忆力超群、阅读量惊人的超级鹦鹉,你给它喂了互联网上几乎所有的公开文本——书籍、百科、新闻、论坛帖子甚至程序代码,这只鹦鹉不满足于简单复述,它通过海量训练,学会了词语之间微妙的连接规律,能根据你的提示,模仿人类的语言方式,生成连贯的句子、回答问题、甚至写诗编程,这只“超级鹦鹉”,就是当下AI大模型的核心缩影。

拆解大模型的核心要素

-

“大”在何处?关键在于规模。

- 海量数据: 它是名副其实的“知识饕餮”,训练使用的数据集规模常常是天文数字,涵盖数万亿甚至更多词汇,这相当于让模型“阅读”了人类文明积累的庞大文本库,从中汲取模式、事实和表达方式,OpenAI的GPT-3训练数据就高达45TB,这为模型提供了极其宽广的知识背景。

- 庞大参数: 参数是模型内部学习到的“规律”和“知识”的数字化存储点,大模型的参数数量动辄达到百亿、千亿乃至万亿级别,你可以把这些参数想象成超级鹦鹉大脑中极其复杂的神经连接网络,其复杂程度决定了模型理解和生成能力的深度与灵活性,GPT-4的参数规模据推测已达万亿级别,远超早期模型。

- 巨量算力: 训练这样的庞然大物,需要成千上万颗高性能处理器(如GPU、TPU)持续运转数周甚至数月,消耗的电力堪比一个小型城镇,每一次模型迭代,背后都是天文数字的计算资源投入,谷歌训练PaLM模型使用了6144块TPU芯片,持续运行了50多天。

-

“模型”如何运作?理解其学习本质。

- 核心任务:预测下一个词。 剥开复杂的外衣,当前主流大模型的核心训练目标其实非常“简单”:在给定上文(一串词)的情况下,预测下一个最可能出现的词是什么?通过在海量文本上反复进行这个预测练习,模型逐渐掌握了语言的统计规律、语法结构、常识逻辑甚至特定领域的专业知识。

- Transformer架构(不必深究,知其关键): 这是支撑大模型的核心引擎,它让模型在处理文本时,能高效地关注到句子中所有相关词汇(无论位置远近),理解上下文之间的复杂联系,正是这种机制,让模型能写出前后连贯、逻辑清晰的长文。

- 涌现能力: 当模型规模(数据和参数)突破某个临界点,会出现令人惊奇的现象——模型展现出在训练数据中并未被明确教授的能力,如复杂推理、代码生成、创意写作等,这并非模型突然有了意识,而是海量参数在复杂模式识别中产生的“质变”效果,GPT-3在训练过程中并未专门学习代码,却展现出了编写程序的能力。

大模型的能力与边界

-

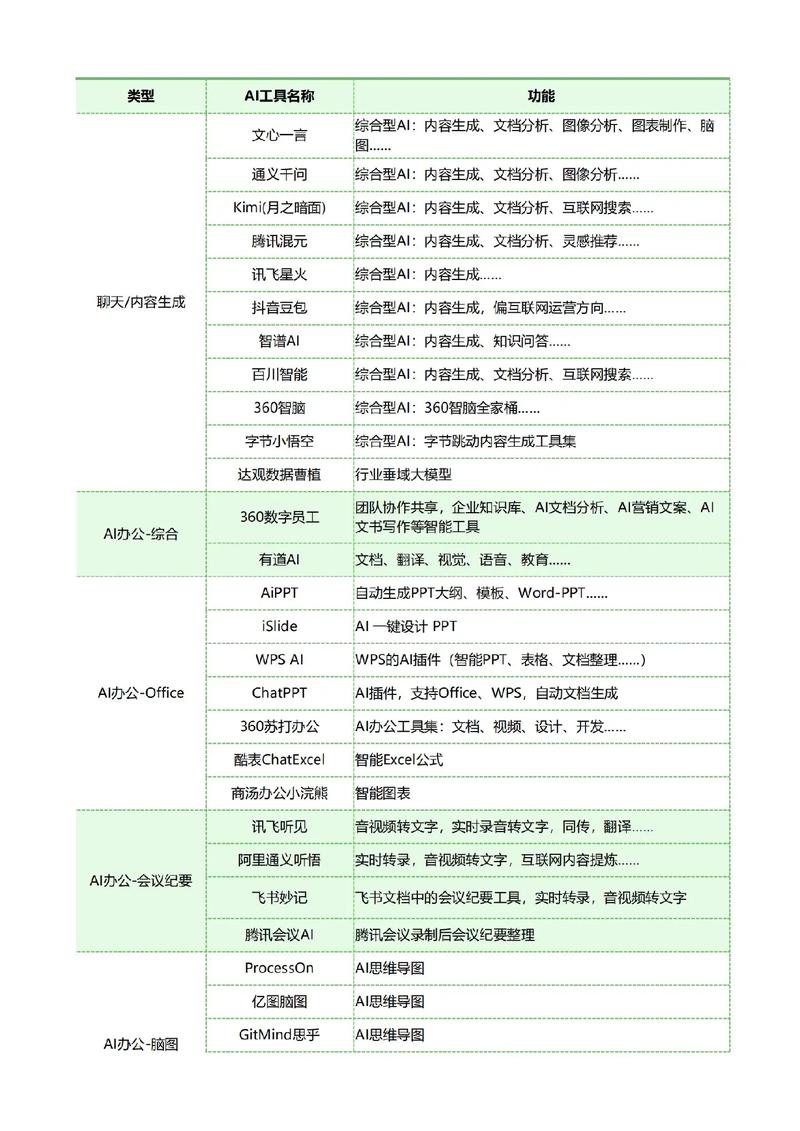

它能做什么?

- 流畅对话: 理解自然语言问题,生成类人回答(如智能客服、聊天机器人)。

- 内容创作: 撰写文章、报告、邮件、营销文案、诗歌、故事脚本。

- 信息提炼: 阅读长文档,总结核心要点,快速提取关键信息。

- 语言转换: 高水平的翻译、改写、润色。

- 编程辅助: 理解需求,生成代码片段、解释代码逻辑、查找错误。

- 知识问答: 利用训练时学到的知识(截止于训练数据日期)回答问题。

- 多模态探索: 结合图像识别技术的多模态模型(如GPT-4V),能理解图片内容,实现“看图说话”。

-

它的局限在哪里?

- 并非真“理解”: 模型本质上是在做高维空间里的复杂模式匹配和概率计算,它没有人类的情感和主观体验,其输出是基于统计规律而非真正的认知理解,当它描述“悲伤”时,只是复现了人类文本中与“悲伤”相关的语言模式。

- “幻觉”风险: 模型可能非常自信地生成听起来合理但完全错误或编造的信息(比如虚构不存在的书籍或事件),这是因为它追求的是语言模式的流畅性,而非事实准确性,今年初谷歌Gemini大模型就曾因生成包含历史人物肤色错误描述的图片而陷入争议。

- 知识时效性: 模型的知识库通常截至其训练数据的最后日期,无法实时获取最新信息(除非额外接入搜索引擎或实时数据库)。

- 缺乏常识与深层推理: 在需要结合物理世界常识、复杂因果链条或深层逻辑推理的场景下,模型可能犯错或给出肤浅答案,它可能无法真正理解“把大象放进冰箱需要几步”背后的物理现实。

- 偏见与安全风险: 模型会继承训练数据中存在的偏见(社会、文化、性别等),也可能被诱导生成有害、歧视性或危险内容,需要严格的安全对齐措施进行约束。

- 依赖提示词(Prompt): 用户输入的问题或指令(Prompt)的质量极大影响输出结果,清晰、具体的提示词才能引导模型给出最佳答案。

个人观点: 将AI大模型视为一种前所未有的强大“概率工具”或“模式引擎”更为贴切,它通过海量数据和计算,掌握了人类语言和知识的表层关联与统计规律,能高效模仿、生成和重组信息,它的价值在于极大提升了信息处理、内容创作和基础自动化的效率,务必清醒认识其本质:它不具备意识、情感和真正的理解力,其输出需要人类智慧的严格审视、事实核查和伦理把关,驾驭好这个工具,关键在于理解其运作原理和边界,既不神话,也不贬低,用人类的判断力为其导航。