在人工智能技术快速发展的今天,各类AI大模型层出不穷,面对众多选择,如何判断一个模型的优劣,成为许多用户关心的问题,一个好的AI模型,不仅要在技术上过硬,更应在实际应用中表现出稳定、可靠和实用的特性。

评价模型的核心能力,可以从四个关键维度入手:理解能力、生成质量、逻辑一致性和安全伦理水平。

理解能力是模型的基础,优秀的模型能够准确把握用户输入的意图,即使问题表述不够清晰或存在错别字,也能通过上下文理解核心需求,你可以尝试提出复杂或多层次的问题,观察模型是否能够抓住重点,避免答非所问,注意模型对专业领域问题的理解深度,是否能够识别特定行业的术语和语境。

生成质量直接决定使用体验,好的模型应当生成流畅、自然且符合语言习惯的文本,生成内容应当结构清晰,逻辑连贯,避免重复、矛盾或突然转换话题,你可以要求模型生成不同形式的文本,如邮件、报告、故事或诗歌,检验其语言创造力和适应性,内容的准确性和信息密度同样重要,空泛笼统的回复往往意味着模型能力有限。

逻辑一致性是区分模型水平的关键指标,高质量的模型在复杂推理和长文本对话中能保持前后一致,不会自相矛盾,你可以设计需要多步推理的问题,或与模型进行多轮对话,测试其记忆能力和逻辑稳定性,模型应当能够承认知识的局限性,对不确定的内容给出谨慎的回应,而不是随意编造信息。

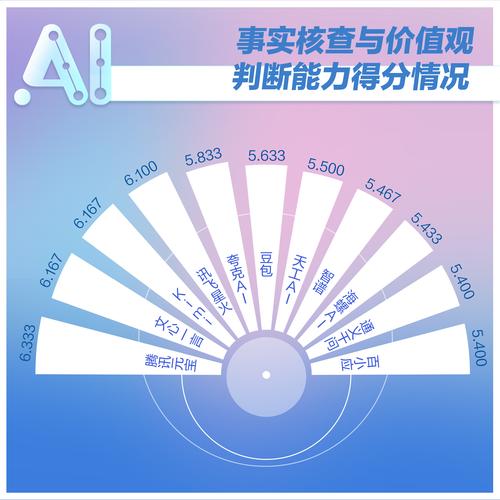

安全与伦理是现代AI系统不可忽视的方面,负责任的模型应当具备内容过滤机制,能够识别并拒绝生成有害、偏见或不合规的内容,模型应保持中立客观,避免隐含的价值观强加,你可以尝试提出敏感或边缘性问题,观察模型的应对方式是否符合伦理规范。

除了这些核心能力,还有一些实用方法可以帮助你评估模型。

实际测试是最好的验证方式,不要仅仅依赖技术指标或宣传文案,亲自使用模型完成你关心的真实任务,准备一组典型问题,涵盖日常使用场景,对比不同模型的表现,注意模型响应速度是否稳定,长时间使用是否会出现性能下降。

关注模型的持续学习能力,人工智能领域发展迅速,好的模型应当能够及时更新知识库,跟上时代变化,你可以询问近期事件或新兴概念,检验模型的知识更新程度。

极端案例测试往往能暴露问题,尝试提出特别复杂、模糊或反常规的问题,观察模型的应对策略,优秀的模型能够妥善处理边界情况,给出合理的回应,而不是简单地报错或拒绝回答。

计算资源效率也是考量因素之一,虽然普通用户可能不直接关注模型参数规模,但响应速度和资源消耗会影响使用体验,高效的模型能够在合理资源消耗下提供优质服务。

开源透明性对于技术团队来说尤为重要,开放架构和训练细节的模型通常更值得信赖,允许用户深入了解其工作机制和潜在局限性。

作为行业观察者,我认为评估AI大模型需要综合考量,没有单一指标能够全面反映模型质量,技术参数固然重要,但最终还是要回归到实际应用场景中检验,最适合的模型不一定是最庞大或最知名的,而是能够在特定使用场景中稳定、可靠、安全地提供服务的解决方案,随着技术不断发展,评估标准也会持续演进,保持开放心态和批判性思维,才能做出明智的选择。