要构建一个属于自己的AI模型,尤其是类似GPT(生成式预训练变换模型)这样的大型语言模型,是一项复杂但并非不可企及的工程,这个过程融合了数据科学、软件工程和大量的计算资源,下面将为您系统地拆解构建过程,帮助您理解其核心脉络。

理解GPT模型的核心

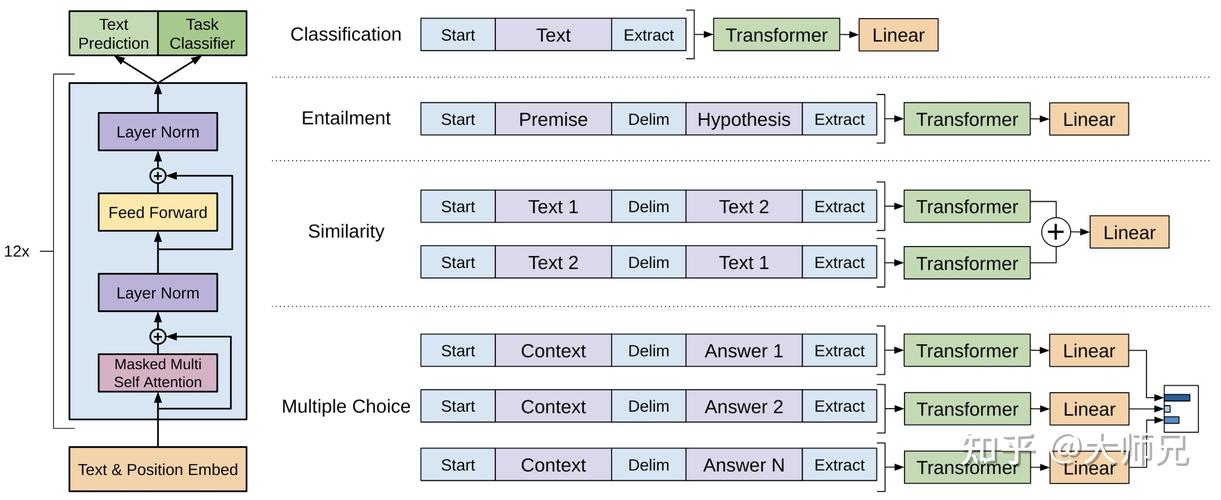

在动手之前,关键在于理解GPT是什么,它是一种基于Transformer架构的神经网络,通过在海量文本数据上进行“预训练”,学习语言的统计规律和知识,之后,它可以被“微调”以适应特定的任务,如对话、翻译或写作,其核心能力在于,根据给定的上文,预测下一个最可能出现的词或字,从而生成连贯的文本。

构建流程的四大支柱

构建一个功能完整的GPT模型,可以概括为四个主要阶段:数据准备、模型构建、训练与优化、部署与应用。

第一支柱:数据准备——模型的基石

数据是AI模型的血液,其质量直接决定模型的智能上限。

- 数据收集: 您需要收集海量、高质量、多样化的文本数据,来源可以包括公开的书籍、学术论文、新闻文章、百科全书以及经过严格筛选的网页内容,初始数据量通常以TB为单位。

- 数据清洗与预处理: 这是最耗时但至关重要的步骤,原始数据充满了噪音,需要进行:

- 去重: 移除重复的段落或文档,防止模型产生偏见。

- 格式化: 统一文本格式,清理HTML标签、特殊字符等。

- 质量过滤: 基于规则或模型去除低质量、有害或带有偏见的内容。

- 分词: 将文本分割成模型能够理解的更小单元(如词、子词),使用Byte-Pair Encoding (BPE) 或WordPiece算法,将词汇表控制在一个合理的大小,并有效处理未登录词。

- 数据存储: 处理后的数据需要被高效地存储,以便在训练时能够被快速读取。

第二支柱:模型构建——搭建神经网络

这一阶段是定义模型“大脑”结构的过程。

- 选择架构: GPT系列模型均采用Decoder-Only的Transformer架构,您需要决定模型的大小,即关键参数:

- 参数量: 从几亿到数千亿不等,参数量越大,模型潜力通常越高,但对计算资源的要求也呈指数级增长。

- 层数: Transformer块的堆叠数量。

- 注意力头数: 模型同时关注文本不同部分的能力。

- 隐藏层维度: 每层神经网络的宽度。

- 代码实现: 使用深度学习框架(如PyTorch或TensorFlow)将所选架构用代码实现,对于个人或小团队而言,直接利用Hugging Face等开源社区提供的、经过验证的模型架构是更高效且稳妥的做法。

- 环境搭建: 准备强大的计算环境,训练GPT模型需要大规模的GPU集群,例如使用NVIDIA A100或H100等专业卡,并配备高速网络互联。

第三支柱:训练与优化——赋予模型智能

这是最消耗计算资源和时间的阶段。

- 预训练:

- 目标: 让模型完成“自回归”任务,即根据前面的所有词预测下一个词。

- 过程: 将预处理好的海量数据输入模型,通过反向传播算法不断调整模型的数百万乃至数十亿个参数,使其预测越来越准确,这个过程可能持续数周甚至数月。

- 优化: 使用AdamW等先进的优化器,并采用学习率预热和衰减策略,以稳定训练过程。

- 微调:

- 指令微调: 为了让模型能够遵循人类的指令进行对话,需要使用高质量的指令-回答对数据对预训练模型进行微调,这能教会模型如何“与人交流”。

- 人类反馈强化学习: 这是让模型输出更符合人类价值观和偏好的关键技术,通过人类标注员对模型的不同回答进行排序,训练一个“奖励模型”,然后利用强化学习(如PPO算法)根据这个奖励模型进一步优化微调过的模型,使其回答更加有用、真实和无害。

第四支柱:部署与应用——让模型创造价值

训练好的模型需要被部署到生产环境中,供用户使用。

- 模型压缩: 为满足线上推理的延迟和资源要求,通常需要对模型进行量化(降低权重精度)、剪枝(移除不重要的参数)或蒸馏(用大模型训练一个小模型)。

- 服务化: 将模型封装成API接口,例如使用FastAPI或Triton Inference Server,使应用程序能够方便地调用模型服务。

- 监控与维护: 持续监控模型的性能、响应时间和资源消耗,收集用户反馈,定期用新数据重新训练或微调模型,以应对数据分布变化和性能衰减。

挑战与考量

构建GPT级别的模型绝非易事,您将面临几大核心挑战:

- 算力成本: 训练一次千亿参数模型的成本可能高达数百万美元,这使其主要局限于大型科技公司和研究机构。

- 数据壁垒: 获取足够多且高质量、合法合规的数据是巨大挑战。

- 技术深度: 需要一支精通深度学习、分布式计算和自然语言处理的顶尖团队。

- 能源消耗: 大规模训练会产生显著的碳足迹,是一个需要严肃对待的伦理和环境问题。

对于绝大多数开发者和企业,更现实的路径是:基于开源的大型预训练模型(如LLaMA、ChatGLM等),在自己的特定领域数据上进行微调,这既能大幅降低成本和门槛,又能快速获得一个在垂直领域表现优异的专用模型。

构建AI模型是一场马拉松,而非短跑,它考验的不仅是技术实力,更是对资源的整合能力、对细节的执着以及对长期目标的耐心,从理解一个开源的小模型开始,亲手实践一遍完整的流程,是迈向构建更复杂模型最坚实的第一步。