要创建一个AI语言模型,需要结合计算机科学、语言学和数据处理的多个领域,这个过程涉及从概念设计到实际部署的多个阶段,每个阶段都需要精心规划和执行,下面将详细介绍制作AI语言模型的关键步骤,并分享一些个人见解。

理解AI语言模型的基础

AI语言模型是一种基于人工智能的系统,能够理解和生成人类语言,它通过学习大量文本数据来预测词序列的概率,从而完成对话、翻译或内容生成等任务,这类模型通常依赖于深度学习技术,尤其是神经网络架构,理解这一点是开始制作的基础,因为它帮助确定项目的目标和范围。

数据收集与准备

数据是训练AI语言模型的基石,需要收集大量高质量的文本数据,例如书籍、文章、网页内容或对话记录,数据来源应多样化,以确保模型能适应不同语境和风格,可以使用公开数据集如维基百科或新闻语料库,在收集过程中,必须注意数据的合法性和道德性,避免使用受版权保护或敏感信息。

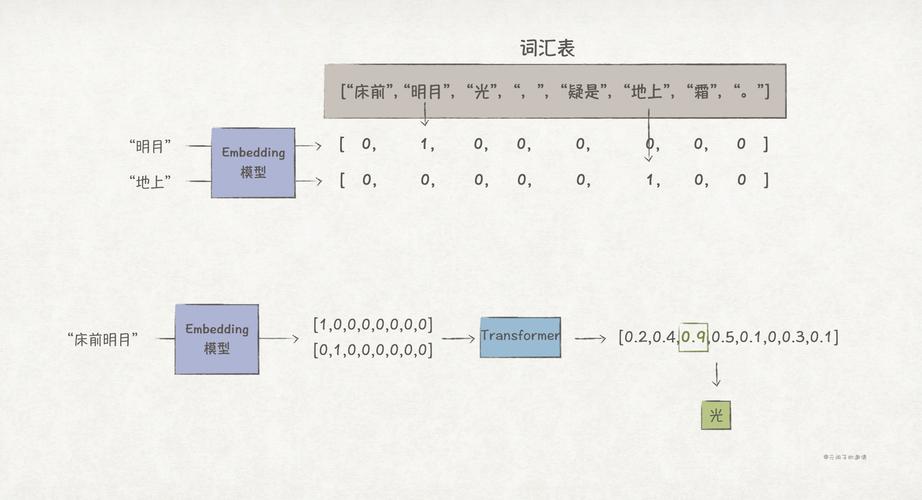

数据预处理是下一步,包括清洗、分词和编码,清洗数据时,需移除无关字符、纠正拼写错误,并统一格式,分词将文本分解为单词或子词单元,而编码则将文本转换为数字形式,便于模型处理,这一阶段的质量直接影响模型的性能,因此需要投入足够时间进行优化。

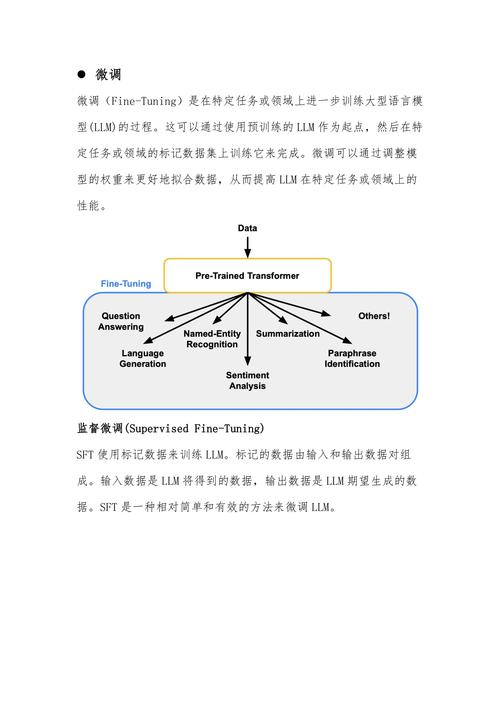

选择模型架构

AI语言模型的核心是神经网络架构,当前,Transformer架构是主流选择,因为它能高效处理长序列数据,并通过自注意力机制捕捉词间关系,GPT系列模型就基于Transformer的解码器部分,在选择架构时,需考虑模型的规模、计算资源和应用场景,小型项目可能从简化版本开始,而大规模应用则需要更复杂的结构。

模型设计还包括定义参数,如层数、隐藏单元数和注意力头数,这些参数影响模型的容量和效率,建议初学者参考现有开源实现,逐步调整以适应特定需求。

训练过程

训练是模型学习的核心环节,需要大量计算资源,通常使用GPU或TPU加速,初始化模型权重,然后通过前向传播计算预测输出,使用损失函数(如交叉熵)衡量预测与真实值的差距,并通过反向传播调整权重,优化器如Adam或SGD用于更新参数,学习率调度则帮助稳定训练。

训练过程中,过拟合是常见问题,可通过正则化技术或早停法缓解,分批处理数据能提高效率,整个过程可能需要数天甚至数周,取决于数据量和模型复杂度,监控训练日志和可视化工具(如TensorBoard)有助于及时调整策略。

评估与优化

训练完成后,需评估模型性能,常用指标包括困惑度(衡量预测不确定性)和准确率,在测试集上验证模型,确保其泛化能力,如果结果不理想,可进行超参数调优或数据增强,调整批量大小或学习率,或添加更多多样化数据。

优化还包括模型压缩和加速,以适应部署环境,技术如量化或剪枝能减少模型大小,同时保持性能,这一阶段需要反复实验,以平衡速度与精度。

部署与应用

将训练好的模型部署到实际环境是最终目标,这涉及集成到应用程序中,如聊天机器人或写作助手,部署时,需考虑延迟、可扩展性和安全性,云服务平台或边缘设备都是常见选择,持续监控和更新模型,以适应新数据和用户反馈,是确保长期有效性的关键。

个人观点

制作AI语言模型是一项充满挑战但极具潜力的工作,它不仅需要技术专长,还要求对伦理和社会影响有深刻理解,随着技术发展,我相信这类模型将更贴近人类思维,推动创新,开发者应始终以负责任的态度,确保技术服务于人类福祉,避免偏见和滥用,通过不断学习和实践,每个人都可以在这一领域贡献自己的力量。