在人工智能浪潮席卷各行各业的今天,无论是开发者、产品经理还是企业决策者,都开始思考如何将强大的AI模型工具融入自己的项目和业务流程中。“调用AI模型”这个听起来技术壁垒很高的操作,其实正变得越来越平民化和标准化,本文将为您梳理调用AI模型的核心思路与实用路径,助您顺利启航AI应用之旅。

第一步:明确需求,选择合适的模型

在开始调用之前,最关键的一步是想清楚“我要用AI解决什么问题”,是想要一个能对话的智能客服?一个能自动生成文章内容的工具?还是一个能识别图像中物体的系统?您的需求直接决定了模型的选择方向。

市面上的AI模型主要分为以下几大类:

- 大型语言模型: 擅长处理文本任务,如内容创作、翻译、代码生成等,代表有GPT系列、Claude、文心一言、通义千问等。

- 视觉模型: 专注于图像和视频的理解与生成,如图像分类、目标检测、图像生成(AIGC),代表有Stable Diffusion、DALL-E、YOLO系列等。

- 语音模型: 处理音频相关任务,如语音识别、语音合成、音频分类。

- 多模态模型: 能够同时理解和处理文本、图像、音频等多种信息,是未来发展的主流方向。

选择模型时,需要权衡模型的性能、成本、易用性和数据隐私等因素,对于大多数非研究型的应用场景,直接利用已经训练好的成熟模型或API服务是最高效的选择。

第二步:探索主流的调用方式

根据您的技术背景和项目需求,可以选择不同层次的调用方式:

使用在线平台与API(最推荐给初学者和快速集成者)

这是目前最简单、最主流的方式,各大科技公司和研究机构都提供了成熟的AI云服务,您无需关心底层服务器和复杂的部署,只需通过API接口即可调用其模型能力。

- 操作流程通常是:

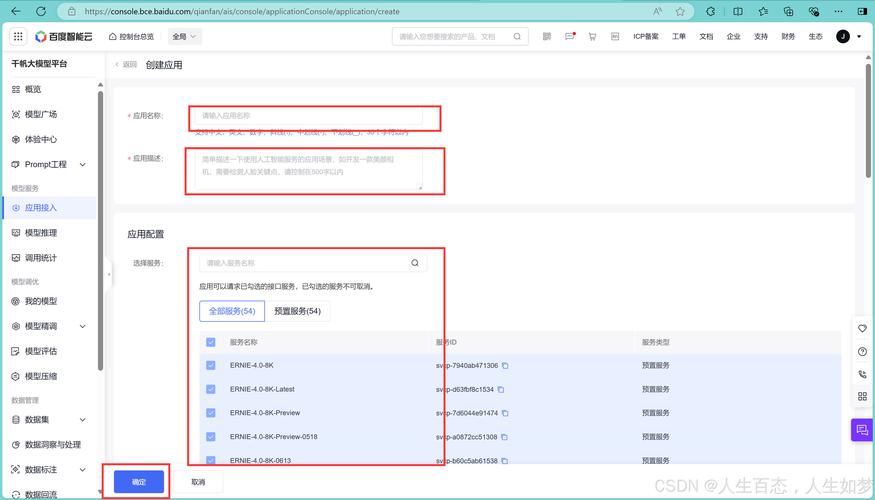

- 注册账号: 在选定的AI服务平台(如OpenAI、百度智能云、阿里云、腾讯云等)注册开发者账号。

- 获取密钥: 在平台后台创建API Key,这是您调用服务的身份凭证,需要妥善保管。

- 查阅文档: 仔细阅读官方提供的API文档,了解请求的格式、参数含义以及返回的数据结构。

- 编写代码调用: 使用您熟悉的编程语言(如Python、JavaScript),通过HTTP请求将数据发送到API地址,并附带您的密钥和请求参数,最后接收并解析返回的结果。

一个极其简化的Python调用代码可能看起来像这样(以伪代码形式展示概念):

import requests

# 您的API密钥和服务端点

api_key = "您的密钥"

api_url = "https://api.example.com/v1/chat/completions"

# 请求头和数据

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

data = {

"model": "gpt-3.5-turbo",

"messages": [{"role": "user", "content": "请介绍一下你自己。"}]

}

# 发送请求并获取响应

response = requests.post(api_url, headers=headers, json=data)

result = response.json()

# 处理结果

print(result['choices'][0]['message']['content'])

使用开源模型与本地部署(适合有技术实力和特定需求的团队)

如果您对数据隐私有极高要求,或者需要对模型进行定制化微调,那么考虑使用开源模型并进行本地部署是更好的选择。

- 典型路径:

- 选择模型: 从Hugging Face等开源社区选择心仪的模型。

- 准备环境: 搭建Python环境,安装必要的深度学习框架,如PyTorch或TensorFlow。

- 下载模型: 将模型文件下载到本地服务器或计算机。

- 加载与调用: 使用框架提供的库加载模型,并编写推理代码。

这种方式给了您最大的控制权,但也带来了硬件成本(需要强大的GPU)、技术维护和部署复杂性的挑战。

利用封装好的工具与软件(无代码/低代码方案)

对于完全不熟悉编程的用户,现在也涌现出大量集成了AI能力的应用软件,一些浏览器插件、办公软件、设计工具(如Canva、Notion AI)内部已经内置了AI功能,用户通过点击按钮、输入指令即可直接使用,完全无需关心调用过程,这是将AI能力“落地”的最快捷方式。

第三步:集成、测试与优化

成功调用模型只是第一步,将其稳定、高效地集成到您的实际应用中才是最终目的。

- 集成: 将调用AI模型的代码封装成函数或服务,嵌入到您的网站、小程序或后台系统中。

- 测试: 进行充分的测试,包括功能测试(输出是否准确)、性能测试(响应速度是否达标)和压力测试(能否承受高并发请求)。

- 优化:

- 提示词工程: 对于LLM而言,精心设计输入给模型的提示词是提升输出质量的关键,清晰、具体的指令往往能带来意想不到的好结果。

- 处理异常: 在网络超时、API限额用完或返回异常结果时,您的程序需要有完善的错误处理机制,保证用户体验。

- 成本控制: 监控API的调用量和费用,设置用量警报,避免产生意外的高额账单。

观点与展望

调用AI模型工具,在今天已经不再是一项高深莫测的“黑科技”,而是一项可以系统化学习和掌握的技能,其核心在于将复杂的AI能力视为一种可插拔的“服务”或“组件”,作为应用者,我们的重心不应仅仅停留在“如何调用”的技术层面,更应深入到“为何调用”以及“如何用好”的战略层面。

思考AI如何为您的用户创造真实价值,如何与您的业务流程无缝融合,并在此过程中不断迭代和优化,这才是驾驭AI力量的根本,随着模型即服务(MaaS)模式的成熟和工具链的进一步完善,调用AI的门槛会持续降低,但基于深刻业务理解的、创造性的应用能力,将始终是稀缺资源,就是开始实践的最佳时机。