在人工智能领域,模型图是一种常见的可视化工具,用于展示算法结构、数据流或决策过程,解析这些图表不仅能帮助理解模型的工作原理,还能优化设计和调试过程,对于初学者或从业者来说,掌握解析方法至关重要,因为它直接影响到模型的应用效率和准确性。

AI模型图通常包括各种元素,如节点、边、层和标签,节点代表操作或数据点,边表示数据流动或连接关系,在神经网络图中,节点可能是神经元,边是权重连接,理解这些基本组成部分是第一步,可以从简单的图表开始,比如线性回归或决策树图,逐步过渡到复杂的结构,如卷积神经网络或Transformer模型。

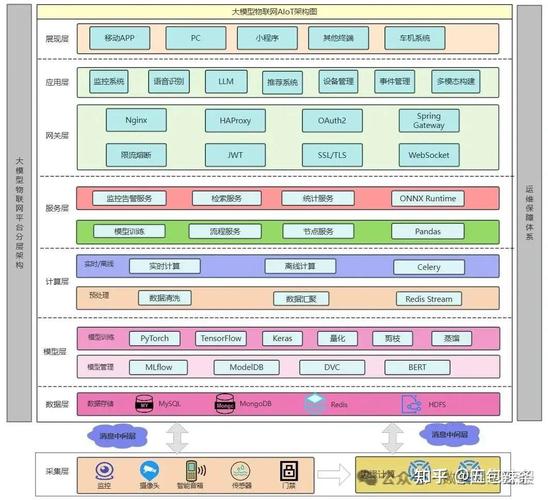

解析时,先观察整体布局,许多模型图采用分层或模块化设计,比如输入层、隐藏层和输出层在神经网络中的排列,注意图表的标题、图例和颜色编码,这些往往提供关键信息,红色可能表示高权重,蓝色代表低值,如果图表包含箭头,它们通常指示数据流向,从输入到输出。

识别关键组件,在深度学习模型中,常见的元素包括卷积层、池化层和全连接层,每个层都有特定功能:卷积层提取特征,池化层减少维度,全连接层进行分类,通过标签或注释,可以了解每个部分的参数,如滤波器大小或激活函数,如果图表显示训练流程,可能包括损失函数、优化器和评估指标,这些细节帮助评估模型性能。

对于更复杂的图,比如注意力机制或生成对抗网络,需要关注交互关系,注意力图可能显示不同部分之间的权重分配,而GAN图通常包含生成器和判别器的对抗流程,这时,分解图表为小块,逐一分析连接和依赖,使用类比或现实例子辅助理解,比如将神经网络比作大脑的神经元网络。

工具和资源可以简化解析过程,许多软件如TensorBoard或Netron专门用于可视化AI模型,它们允许缩放、高亮和查看参数细节,在实践中,动手绘制或修改现有图表能加深理解,用绘图工具重现一个简单模型图,标注每个部分的功能。

个人经验中,解析AI模型图就像学习一门新语言,起初可能感到困惑,但通过反复练习,会逐渐熟悉符号和结构,我建议从开源项目或教程中的图表开始,结合代码实现对照分析,这样不仅能理解理论,还能看到实际应用,解析不是一蹴而就的,需要耐心和持续学习,随着技术进步,图表形式也在演变,保持好奇心是关键,这种技能将提升你在AI项目中的自信和效率。