随着人工智能技术的快速发展,AI模型下载已成为许多应用和工具中的常见功能,无论是开发者还是普通用户,都可能遇到需要关闭自动下载模型的情况,这可能是出于节省网络带宽、减少存储占用、增强隐私保护或适应离线环境等目的,我将从实际应用角度出发,详细说明如何在不同场景下关闭AI模型下载,并提供一些实用建议,帮助您更高效地管理相关设置。

我们需要理解AI模型下载的基本机制,AI模型通常指预训练的机器学习模型,例如用于图像识别、自然语言处理或预测任务的模型,许多框架和应用会默认从远程服务器下载这些模型,以提供最新功能或优化性能,但如果您希望控制这一过程,关闭自动下载是可行的。

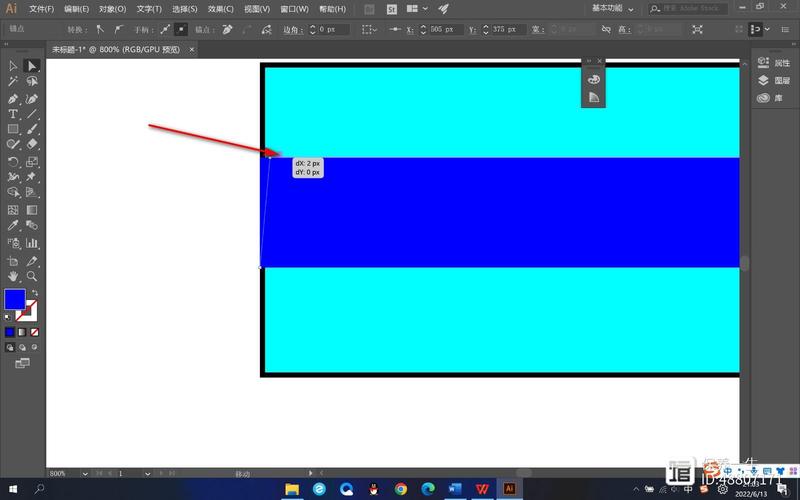

在机器学习开发环境中,关闭模型下载的方法因框架而异,以TensorFlow为例,当使用tf.keras.applications加载预训练模型时,可以通过设置weights参数为None来避免自动下载权重文件,在代码中指定model = tf.keras.applications.ResNet50(weights=None),这样系统就不会从网络获取模型数据,而是依赖本地已存在的文件或自定义初始化,类似地,在PyTorch中,使用torch.hub.load函数时,可以添加force_reload=False并结合本地缓存路径,避免重复下载,设置环境变量如TFHUB_CACHE_DIR或TORCH_HOME指向本地目录,能强制框架使用离线资源,从而屏蔽下载行为。

对于集成AI功能的应用程序,例如手机APP或桌面软件,关闭模型下载通常通过用户设置界面完成,许多应用会在“设置”或“偏好”菜单中提供“自动更新”或“模型下载”选项,您只需将其切换为关闭状态即可,在一些图像处理软件中,禁用“自动下载新模型”可以防止在后台获取大型文件,节省数据流量,检查应用的权限设置,限制其网络访问权限,也能间接阻止下载行为,在操作系统层面,如Windows或macOS,您可以通过防火墙规则屏蔽特定应用的外部连接,但这需要一定的技术知识,建议谨慎操作以确保正常功能不受影响。

在线AI服务或浏览器扩展中,关闭模型下载可能涉及更复杂的配置,一些云平台如Google Cloud AI或AWS SageMaker允许用户在控制台中调整模型部署设置,选择“仅使用本地模型”或禁用自动同步功能,对于浏览器中的AI工具,检查扩展程序的选项页面,寻找“数据下载”或“缓存管理”相关设置,并将其调整为手动模式,清除浏览器缓存和历史数据可以帮助移除已下载的模型文件,但请注意这可能会影响某些功能的正常运行。

在关闭AI模型下载时,有几点需要特别注意,关闭下载后,您可能需要手动管理模型文件,确保本地存储的模型版本与应用需求兼容,否则,可能会出现性能下降或错误,在团队协作或生产环境中,关闭下载可能影响一致性,建议提前测试并文档化相关设置,考虑到安全因素,禁用自动下载可以减少潜在的网络攻击面,但同时也可能错过重要的安全更新,定期检查模型版本和更新日志是必要的。

从个人经验来看,关闭AI模型下载是一种有效的资源管理策略,尤其适用于网络条件有限或对数据隐私要求较高的场景,在开发原型时,我经常选择禁用自动下载,以加快本地调试速度并减少外部依赖,这需要权衡便利性与控制力——如果您不熟悉模型维护,自动下载可能更省心,总体而言,我建议根据具体使用场景做出决策:在测试或离线环境中优先关闭下载,而在生产环境中保持自动更新以确保稳定性,通过合理配置,您可以充分发挥AI技术的优势,同时避免不必要的资源消耗。