在当今人工智能技术飞速发展的时代,AI模型文件已成为许多开发者和研究者的核心工具,无论是用于图像识别、自然语言处理还是预测分析,正确导入这些文件是实现项目目标的第一步,导入过程看似简单,却涉及多个关键环节,包括文件格式识别、环境配置和框架兼容性,本文将详细介绍如何高效地导入AI模型文件,涵盖常见场景和实用技巧,帮助您避免常见陷阱。

了解AI模型文件的基本类型至关重要,常见的格式包括TensorFlow的SavedModel(.pb文件)、Keras的HDF5(.h5文件)、PyTorch的模型检查点(.pth或.pt文件),以及跨平台的ONNX(.onnx文件),每种格式对应不同的框架和工具链,因此在导入前,务必确认文件来源和预期用途,TensorFlow模型通常用于生产环境,而PyTorch模型更常见于研究阶段。

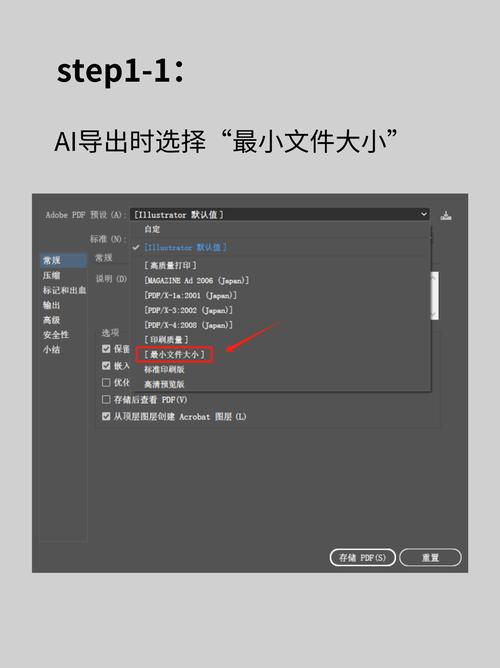

我们分步骤探讨导入过程,第一步是准备环境:确保您的开发环境已安装必要的库和依赖,以Python为例,如果您使用TensorFlow,可以通过pip安装tensorflow库;对于PyTorch,则安装torch库,检查库版本是否与模型文件兼容,因为版本不匹配可能导致导入失败,一个用TensorFlow 2.x保存的模型可能无法在1.x环境中加载,建议使用虚拟环境(如venv或conda)来隔离项目,避免冲突。

第二步是文件加载,不同框架提供了各自的API来处理模型文件,在TensorFlow中,您可以使用tf.saved_model.load()函数导入SavedModel格式的文件,代码示例如下:

import tensorflow as tf

model = tf.saved_model.load('path/to/model')

对于Keras的HDF5文件,则使用tf.keras.models.load_model():

model = tf.keras.models.load_model('path/to/model.h5')

在PyTorch中,导入模型通常涉及加载状态字典,定义模型架构(与训练时相同),然后使用torch.load()加载文件,最后应用load_state_dict()方法:

import torch

model = YourModelClass() # 替换为您的模型类

model.load_state_dict(torch.load('path/to/model.pth'))

model.eval() # 设置为评估模式

对于ONNX格式,由于其跨平台特性,您可以使用ONNX Runtime进行导入,安装onnxruntime库后,通过以下代码加载模型:

import onnxruntime as ort

session = ort.InferenceSession('path/to/model.onnx')

第三步是验证导入结果,加载模型后,进行简单测试以确保功能正常,输入一个样本数据,检查输出是否符合预期,这有助于发现潜在问题,如形状不匹配或数据类型错误,注意模型是否处于训练或推理模式;在PyTorch中,使用model.eval()可切换到推理模式,避免不必要的计算。

在实际操作中,可能会遇到一些挑战,文件路径错误是常见问题,务必使用绝对路径或正确相对路径,依赖缺失可能导致导入失败;建议查阅模型文档,确认所需库是否齐全,对于大型模型,内存不足也可能成为障碍,这时可以考虑分块加载或使用云资源。

除了基本导入,还需考虑性能优化,在TensorFlow中,启用GPU加速可以大幅提升推理速度;在PyTorch中,使用torch.jit.script进行模型序列化可能提高效率,安全性和可维护性不容忽视:定期备份模型文件,并使用版本控制工具(如Git)管理代码,确保项目可重现。

从个人经验来看,导入AI模型文件不仅是技术操作,更是一种艺术,它要求我们具备系统思维,从环境搭建到错误处理,每一步都需谨慎,随着AI工具生态的不断演进,新格式和框架层出不穷,保持学习和适应能力是关键,近年来ONNX的普及使得模型交换更加便捷,这体现了开源社区的协作精神,我相信,掌握导入技能不仅能加速项目进展,还能深化对AI系统整体架构的理解。

通过上述步骤和注意事项,您可以更自信地处理AI模型文件导入任务,实践出真知——多尝试不同场景,积累经验,才能游刃有余,在AI的世界里,每一步探索都可能带来新的突破,愿您在技术道路上不断前行。