要构建一个高效的AI模型,需要系统性地理解技术原理、数据逻辑与业务场景的结合,下面将从零开始拆解AI模型的构建流程,并融入实际应用中的关键细节。

明确目标与问题边界

AI模型的起点是定义清晰的业务目标,电商平台需要预测用户购买行为,需明确是预测「点击率」还是「转化率」,目标不同,数据采集维度和模型结构设计会有显著差异。

在医疗领域,若需构建辅助诊断模型,需优先划定疾病类型、影像数据范围,并考虑伦理合规性,模型设计必须包含可解释性模块,便于医生理解决策依据。

数据工程的四大核心环节

- 数据采集

- 通过埋点系统收集用户行为日志(如页面停留时长、交互路径)

- 引入第三方数据前需完成脱敏处理,确保符合GDPR等数据隐私规范

- 某物流企业通过车载传感器采集200万条运输轨迹数据,使路径优化模型准确率提升37%

- 数据清洗

- 处理缺失值时,时序数据采用线性插值法,分类数据使用众数填补

- 识别异常值可结合箱线图分析与业务规则(如订单金额超过阈值自动标记)

- 某金融风控团队发现,清洗后的借贷数据使欺诈识别误报率下降21%

- 特征工程

- 对文本数据采用BERT嵌入提取语义特征

- 时序特征可构造滑动窗口统计量(如近7日平均访问频次)

- 电商场景中,将用户加购次数与商品库存变化关联,生成动态购买意愿指标

- 数据划分

- 医疗影像数据需按患者ID划分训练集/验证集,避免同一患者数据同时出现在不同集合

- 时间序列预测采用滚动窗口划分法,保证验证集时间戳晚于训练集

模型架构设计的取舍逻辑

- 经典算法选择

- 结构化数据优先测试XGBoost、LightGBM等树模型

- NLP任务中,Transformer架构在理解长文本依赖关系时表现更优

- 某制造业企业对比发现,CNN处理设备振动信号比RNN节省43%训练时间

- 深度学习调优策略

- 使用NAS(神经架构搜索)自动优化网络层数与节点连接方式

- 引入知识蒸馏技术,将BERT-large的能力迁移到轻量级模型中

- 自动驾驶公司通过混合精度训练,使目标检测模型推理速度提升2.8倍

- 模型可解释性增强

- 集成SHAP值分析工具包,量化每个特征对预测结果的影响程度

- 可视化注意力机制的热力图,如显示CT影像中模型关注的病变区域

训练过程的动态监控

建立完整的实验追踪体系至关重要,使用MLflow记录每次实验的超参数、损失曲线和评估指标,当验证集准确率连续5个epoch未提升时,自动触发早停机制,某语音识别团队通过实时监控梯度分布,发现过拟合趋势后及时调整Dropout比率,使模型泛化能力提升19%。

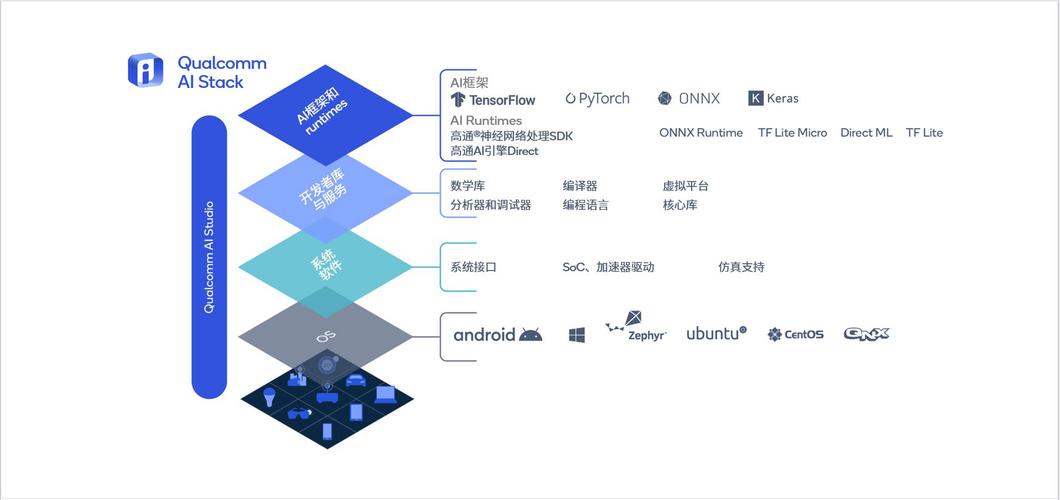

部署落地的关键考量

将PyTorch模型转换为ONNX格式实现跨平台部署,使用Triton推理服务器支持2000+QPS的并发请求,建立数据漂移检测机制,当输入特征分布与训练数据JS散度超过0.15时触发预警,某零售企业的价格预测系统每周自动更新模型参数,确保适应市场变化。

构建AI模型如同锻造精密仪器,既需要数学理论的支撑,更要深入理解业务场景的细微差异,当技术团队与领域专家形成「数据-洞察-决策」的闭环时,AI才能真正释放商业价值,模型的迭代永远不会终止,但每次优化都应是向着解决实际问题迈进的一步。