明确目标与场景定义

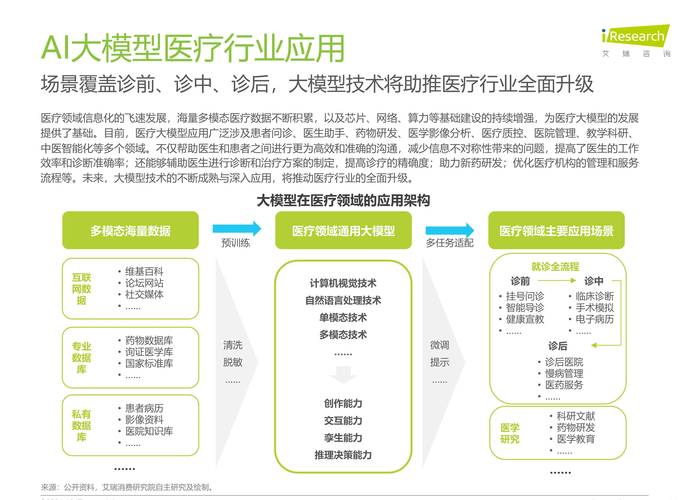

构建AI模型的第一步是清晰界定模型的应用场景,2024年AI技术已渗透到医疗诊断、自动驾驶、工业质检等具体领域,每个场景对模型的精度、响应速度、可解释性均有不同要求,金融风控模型需强调预测准确率,而实时翻译工具则更关注低延迟处理能力。

建议采用“问题拆解法”:将复杂业务需求拆解为可量化的技术指标,电商推荐系统可分解为点击率预测、用户分群、商品关联分析等多个子任务,再针对每个任务设计对应的模型架构。

数据工程的四大核心环节

数据质量直接影响模型性能,2024年主流的数据处理流程包含以下关键步骤:

-

多模态数据采集

融合文本、图像、传感器数据等多种来源,例如智能工厂的质检系统需同时处理生产线摄像头画面与设备振动信号,采用自动化标注工具提升效率,同时通过对抗生成网络(GAN)扩充稀缺样本。

-

特征工程优化

使用自动化特征选择工具(如FeatureTools)识别高价值变量,对时序数据采用滑动窗口技术提取趋势特征,文本数据则通过BERT等预训练模型生成语义向量。 -

数据隐私保护

遵守GDPR等法规,采用联邦学习框架或差分隐私技术,在保证数据可用性的前提下避免原始信息泄露,医疗领域可通过合成数据生成技术创建脱敏数据集。

-

版本化管理

使用DVC(Data Version Control)工具记录数据变更历史,确保实验可复现性。

模型架构选择的三大趋势

2024年的模型设计呈现专业化与轻量化并行的特点:

-

领域定制化模型

通用大模型逐步转向垂直领域优化,法律行业采用Legal-BERT处理合同文本,农业领域使用结合卫星遥感数据的CNN-Transformer混合模型。 -

边缘计算适配

通过知识蒸馏、量化压缩技术,将百亿参数模型压缩至10MB以内,适配手机、IoT设备,TensorFlow Lite与ONNX Runtime成为主流部署工具。 -

可解释性增强

引入SHAP值分析、注意力可视化模块,特别是在医疗、司法等高风险场景,模型需提供决策依据的透明化说明。

训练阶段的实战技巧

-

超参数自动化调优

使用Optuna或Ray Tune进行并行化搜索,相比网格搜索效率提升5-8倍,重点优化学习率衰减策略与批量归一化参数。 -

对抗训练提升鲁棒性

在图像识别任务中加入对抗样本训练,使用FGSM(Fast Gradient Sign Method)增强模型抗干扰能力,自然语言处理领域可通过回译(Back Translation)增加文本多样性。 -

分布式训练加速

采用Horovod框架实现多GPU并行计算,结合混合精度训练(FP16+FP32)降低显存占用,对于超大规模模型,可使用Megatron-LM进行3D并行切分。

模型评估与持续迭代

2024年模型评估标准已超越传统准确率指标,更关注业务价值转化:

-

业务指标对齐

广告推荐模型需关联ROI(投资回报率),工业预测模型需计算故障误判带来的成本损耗,建议建立离线仿真环境模拟真实业务流。 -

模型监控体系

部署Prometheus+Grafana监控平台,实时追踪预测结果分布偏移(Data Drift),当输入数据特征统计量变化超过阈值时触发自动重训练。 -

持续学习机制

设计增量学习流程,利用新数据动态更新模型参数,避免全局重训练带来的资源消耗,推荐使用Elastic Weight Consolidation(弹性权重固化)算法防止灾难性遗忘。

个人观点

当前AI模型开发已进入“精细化运营”阶段,单纯追求技术前沿性可能带来资源浪费,开发者更需关注三个平衡:算力成本与效益的平衡——选择性价比最高的模型规模;技术创新与合规风险的平衡——在模型设计中嵌入隐私保护与伦理审查机制;短期需求与长期演进的平衡——通过模块化架构设计保持系统扩展性,未来两年,能在特定场景中实现“稳定输出商业价值”的模型,将比单纯追求技术指标的模型更具生命力。