理解SD AI模型包的基本概念

SD(Stable Diffusion)AI模型包是一种基于深度学习的图像生成工具,能够通过文本描述或现有图像生成高质量视觉内容,其核心原理是通过预训练的神经网络模型,将用户输入的指令转化为像素级图像,对于普通用户而言,SD AI模型包的价值在于快速实现创意设计、艺术创作,甚至辅助商业项目中的视觉内容生产。

准备工作:环境与资源

-

硬件要求

- 显卡:推荐NVIDIA显卡(显存≥8GB),支持CUDA加速运算。

- 内存:16GB及以上,避免生成高分辨率图像时卡顿。

- 存储空间:至少预留20GB,用于存放模型文件及临时数据。

-

软件依赖

- 操作系统:Windows 10/11、Linux或macOS(需额外配置)。

- 运行环境:安装Python 3.8以上版本,并配置PyTorch框架。

- 工具支持:建议使用整合包(如AUTOMATIC1111的WebUI),简化部署流程。

-

模型文件获取

- 官方渠道:从Hugging Face或GitHub下载基础模型(如SD 1.5、SDXL)。

- 社区资源:部分第三方平台提供微调后的模型(需注意版权声明)。

部署与安装流程

-

下载整合包

选择成熟的整合工具(如Stable Diffusion WebUI),解压至本地文件夹。 -

配置模型文件

- 将下载的模型文件(.ckpt或.safetensors格式)放入指定目录(通常为

/models/Stable-diffusion)。 - 若需使用附加功能(如ControlNet),需额外下载插件并放置到对应路径。

- 将下载的模型文件(.ckpt或.safetensors格式)放入指定目录(通常为

-

启动运行环境

- 双击运行启动脚本(如

webui-user.bat),系统会自动安装依赖项。 - 首次启动时间较长,完成後浏览器将自动打开本地端口的Web界面(如

http://127.0.0.1:7860)。

- 双击运行启动脚本(如

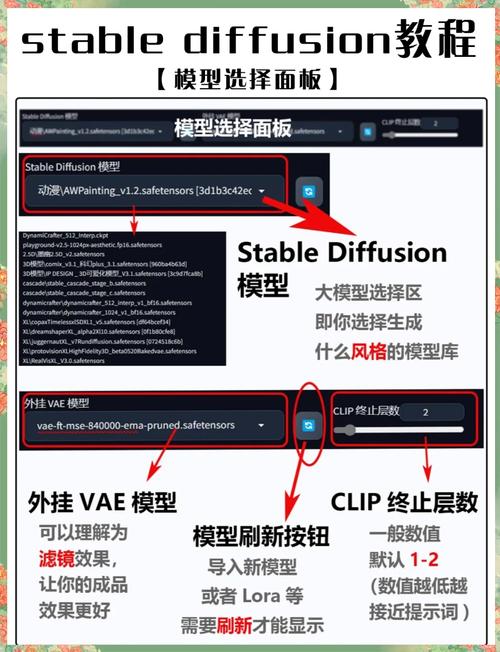

核心功能操作指南

-

文生图(Text-to-Image)

- 在提示词框(Prompt)输入描述语句,“科幻城市,未来风格,霓虹灯光,4K细节”。

- 反向提示词(Negative Prompt)可排除不想要的元素,如“模糊,水印,低分辨率”。

- 调整参数:

- 采样步数(Steps):20-30步平衡速度与质量。

- 图像尺寸(Width/Height):建议不超过显存承载范围(如512x768)。

- 提示词相关性(CFG Scale):7-12之间效果较稳定。

-

图生图(Image-to-Image)

- 上传参考图,设置去噪强度(Denoising Strength)。

- 强度值越低,生成结果越接近原图;值越高,创意自由度越大。

-

高级控制

- LoRA模型:加载风格化微调模型,快速切换画风。

- ControlNet插件:通过边缘检测、姿态识别等功能精准控制构图。

常见问题与解决方案

-

模型加载失败

- 检查文件格式是否兼容,部分整合包仅支持特定类型的模型文件。

- 确认模型存放路径无误,重启WebUI尝试重新加载。

-

显存不足报错

- 降低图像分辨率或批量生成数量。

- 启用显存优化选项(如

--medvram启动参数)。

-

生成效果偏离预期

- 优化提示词:增加细节描述,使用英文关键词(部分模型对英文理解更精准)。

- 调整CFG Scale值,避免过高导致图像过度饱和。

提升使用效率的技巧

- 预设模板:将常用参数组合保存为模板,减少重复设置时间。

- 批量生成:利用脚本功能一次性生成多组图像,筛选最佳结果。

- 社区资源:关注开源社区(如Civitai),获取优质提示词组合与模型推荐。

个人观点

SD AI模型包的普及降低了创意设计的门槛,但其真正价值取决于用户对技术的理解与应用场景的结合,初学者可能会被复杂的参数设置劝退,建议从基础功能入手,逐步探索高级玩法,模型生成内容需注意版权风险,尤其在商业用途中,务必核查训练数据的合规性,工具再强大,最终决定效果的仍是使用者的创意与判断力。