从零开始掌握AI翻唱工具:操作指南与深度解析

近年来,AI翻唱技术迅速崛起,成为音乐创作领域的热门话题,无论是普通用户尝试趣味创作,还是专业音乐人探索新灵感,AI翻唱模型都提供了更多可能性,但对于初次接触这项技术的人来说,如何正确使用这些工具仍存在诸多疑问,本文将从基础操作到进阶技巧,系统解析AI翻唱模型的应用方法,并探讨其背后的技术逻辑与注意事项。

AI翻唱模型的核心原理

AI翻唱的实现依赖于深度学习技术,尤其是语音合成(TTS)和声纹转换(VC)的结合,模型通过大量训练数据学习人声特征,包括音色、音高、情感等,最终实现将任意人声替换为特定歌手音色的效果,当前主流的开源框架如So-VITS、DiffSinger等,均基于这一逻辑构建。

值得注意的是,AI翻唱并非简单的“声音替换”,优秀模型还能保留原始演唱的呼吸节奏、情感起伏,甚至修复原声中的瑕疵,这要求模型具备高精度音频分离能力与复杂的特征提取算法。

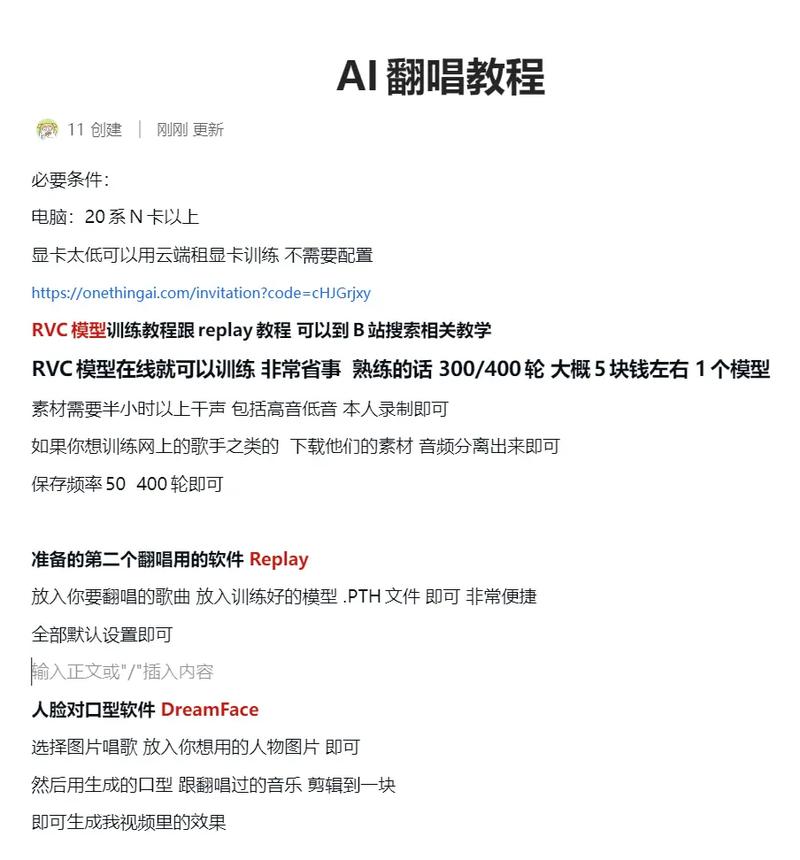

操作步骤详解:从入门到实践

准备工作

- 硬件配置:建议使用配备独立显卡(如NVIDIA RTX 3060以上)的电脑,显存8GB以上可显著提升训练速度。

- 软件环境:安装Python 3.8+、PyTorch框架及CUDA驱动,推荐使用Anaconda管理依赖库。

- 数据采集:若需训练自定义音色,需准备目标歌手15分钟以上的干声素材(无伴奏人声),采样率建议44.1kHz。

模型选择与部署

- 预训练模型:新手可从Hugging Face等平台下载现成模型(如RVC、OpenVoice),直接加载使用。

- 本地部署:以RVC为例,通过Git克隆仓库后安装requirements.txt中的依赖项,按文档指引配置权重文件。

数据处理与训练

- 音频预处理:使用UVRTools或Spleeter分离伴奏与人声,去除噪音。

- 特征提取:通过模型提取音高(F0)与音色特征(HuBERT),生成训练所需的索引文件。

- 模型训练:设置合适的学习率(推荐0.0001)、批量大小(根据显存调整),训练时长通常需4-8小时。

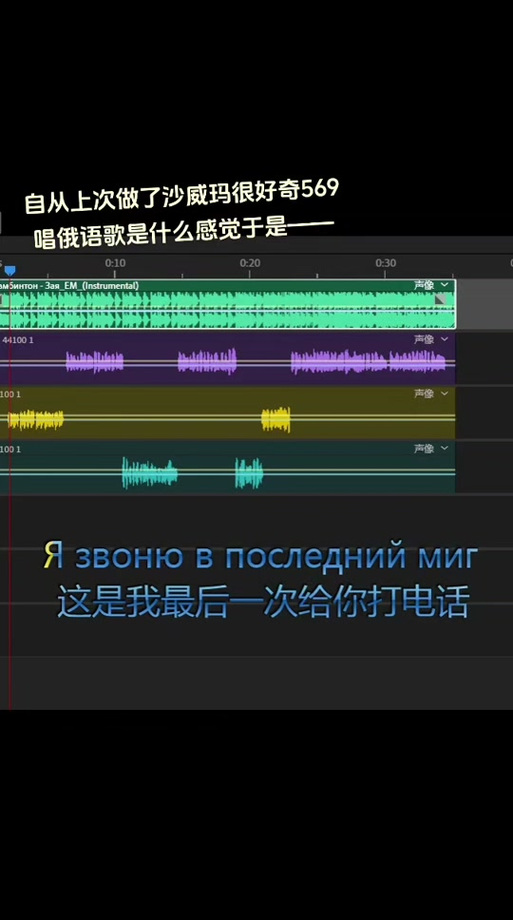

生成与调优

- 推理阶段:输入待转换的干声音频,选择目标音色模型,调整音高偏移参数(pitch shift)适配歌曲调性。

- 后处理:使用iZotope RX等工具修复爆音、齿音问题,混响效果器可增强空间感。

关键问题与解决方案

音色不自然?检查三大要素

- 数据质量:训练素材需避免环境噪音与设备底噪。

- 特征对齐:使用Praat工具手动校正音高曲线,确保模型正确捕捉演唱细节。

- 过拟合控制:添加Dropout层(概率0.2-0.5),限制训练步数(推荐200-400轮)。

版权风险规避指南

- 素材合法性:仅使用已授权或CC0协议的音频进行训练。

- 商业化限制:多数开源模型禁止将生成内容用于商业用途,需仔细阅读许可协议。

- 署名要求:部分平台要求标注“AI生成”标签,建议参考《生成式AI服务管理办法》。

提升效果的进阶技巧

- 多模型融合:将So-VITS的音色转换与Diffusion模型的自然度增强结合使用。

- 动态参数调整:针对歌曲副歌部分单独提高音色强度(rms_mix_rate参数)。

- 情感控制:在推理阶段添加情感标签(如“激昂”“悲伤”),引导模型输出特定风格。

技术边界与伦理思考

AI翻唱虽降低了音乐创作门槛,但也引发争议,2023年某明星AI翻唱专辑纠纷案显示,未经授权的音色使用可能侵犯人格权,技术爱好者需明确:工具本身无善恶,关键在于使用者的选择。

从技术发展角度看,AI翻唱正在推动音乐产业变革,唱片公司开始建立“音色版权库”,音乐教育领域则利用AI模拟大师演唱进行教学,这些应用证明,当技术被规范使用时,其创造的价值远超娱乐范畴。

个人观点

AI翻唱模型的普及,本质是创作民主化的延伸,它让更多人无需专业录音设备即可表达音乐创意,但同时也要求我们建立更完善的技术伦理框架,作为使用者,既要保持对新工具的探索热情,也需对原创者保持敬畏——技术永远无法替代人类情感的真实共鸣。