人工智能大模型训练是当前科技发展的热点,尤其在中国,随着政策支持和产业投入,国内企业正加速布局,训练一个高效的大模型涉及多个复杂环节,从数据准备到模型优化,每一步都需要精心设计,本文将深入解析国内AI大模型的训练过程,帮助读者理解其核心机制。

数据收集是训练的基础,企业优先使用本土数据源,如公开语料库、新闻网站和用户生成内容,这些数据需经过严格清洗,去除噪声和敏感信息,确保合规性,百度文心一言的训练中,团队整合了海量中文文本,覆盖文学、科技和日常对话,以增强模型的语义理解能力,数据预处理包括分词、编码和平衡采样,避免偏见,国内企业注重数据安全,遵守《网络安全法》,通过脱敏技术保护用户隐私,体现对伦理的重视。

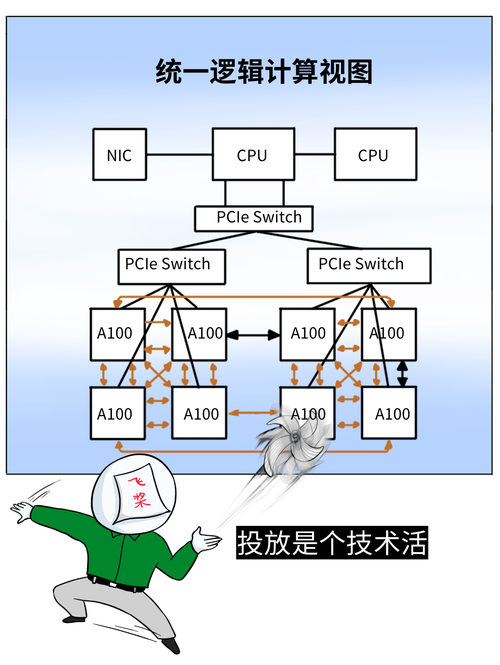

模型架构选择是关键一步,Transformer结构是主流,因其并行处理能力适合大规模训练,国内团队常基于开源框架如PyTorch或TensorFlow构建,但也在自主研发上发力,阿里巴巴的通义千问就优化了注意力机制,针对中文特点调整层数和参数,提升效率,训练开始时,模型通过预学习阶段吸收通用知识,使用无监督方法预测下一个词或掩码词,这一过程消耗巨大计算资源,国内云服务如华为昇腾或腾讯云提供分布式集群,支持GPU加速,缩短训练时间。

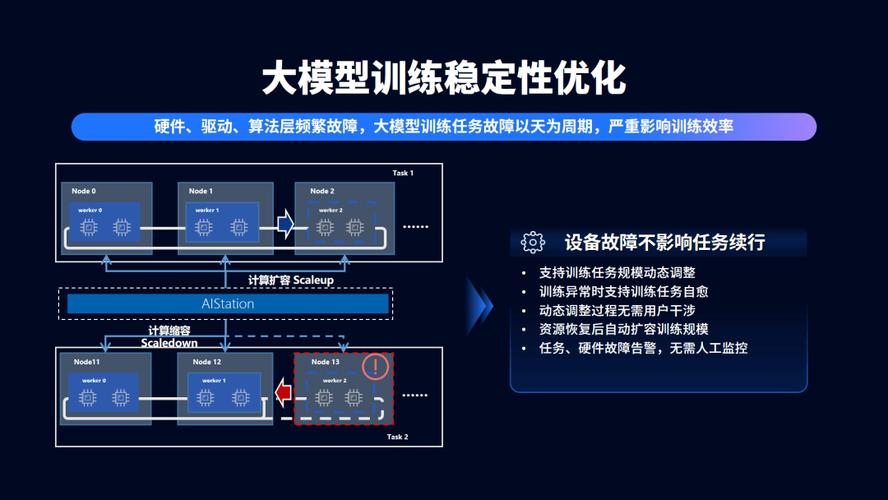

训练过程本身需要高效算法和硬件协同,分布式训练是核心,数据被分割到多个节点并行处理,减少瓶颈,优化算法如AdamW帮助调整学习率,防止过拟合,企业面临独特挑战,如语言复杂性和文化语境,为解决这些问题,微调阶段至关重要:模型在特定任务数据集上细化,比如中文问答或情感分析,百度的实践表明,引入强化学习能让模型从用户反馈中迭代优化,提升准确率,国内团队常采用知识蒸馏技术,将大模型的知识压缩到轻量级版本,便于部署到移动端。

计算资源管理不容忽视,训练一个大模型动辄需要数千GPU小时,能耗巨大,中国企业积极推动绿色AI,通过算法优化降低碳足迹,某些项目使用混合精度训练,减少内存占用,政策支持如“新一代人工智能发展规划”提供资金和基础设施,助力企业突破瓶颈,数据稀缺性和质量波动仍是难题,国内研究机构正探索合成数据生成,补充真实样本。

在应用层面,国内AI大模型训练强调实用性,模型最终服务于搜索、推荐系统或智能客服,需通过严格测试,评估指标包括困惑度和人工评测,确保输出可靠,个人观点上,中国AI大模型的训练路径展现了创新活力,未来在自主可控和跨领域融合上潜力巨大,政策引导与市场需求结合,将推动技术更贴近民生,创造全球影响力。(字数:约1100字)