开源AI模型训练实战指南:释放技术潜能

当ChatGPT点燃全球AI热潮,你是否好奇这些强大的模型如何诞生?开源AI模型的兴起,正将曾经实验室里的尖端技术,转变为开发者触手可及的工具,训练属于自己的AI模型,不再是科技巨头的专利。

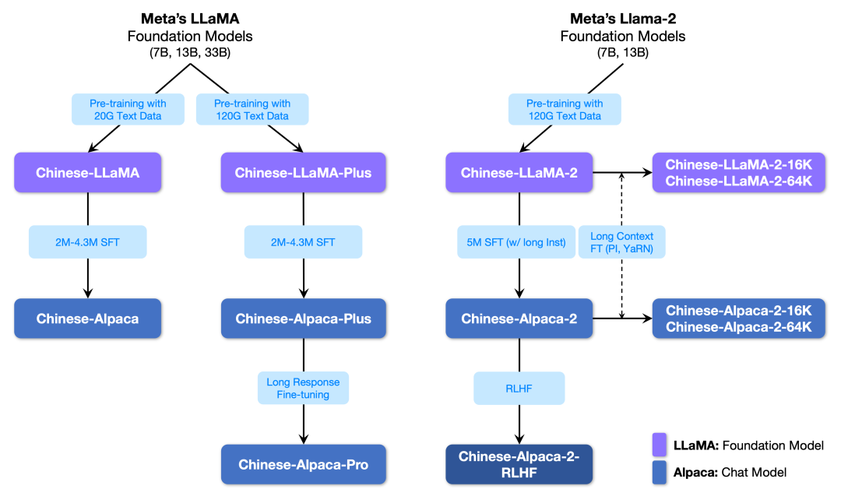

开源模型:技术民主化的核心力量 开源AI模型公开了架构与训练方法,大幅降低了技术门槛,从Meta的Llama到Mistral,再到DeepSeek,这些开源项目不仅提供预训练基础,更允许我们基于此进行个性化训练,这打破了技术垄断,让创新不再受限于资源。

实战训练:从准备到部署的核心步骤

-

明确目标与选择模型:

- 任务定义: 清晰界定模型用途——是生成文本、识别图片、还是分析数据?目标决定了模型类型(如LLM、扩散模型)。

- 模型筛选: Hugging Face Hub等平台汇聚海量开源模型,根据任务需求、硬件条件(如GPU显存)、许可协议(商用限制?)综合评估,7B参数的模型在24G显存显卡上即可微调。

-

构建高质量数据集:

- 数据为王: 模型表现直接取决于数据质量,摒弃“那些”不相关或低质信息。

- 针对性收集与清洗: 围绕目标任务收集数据,如训练客服助手,需大量相关问答记录;训练绘画模型,则需优质图片及文字描述,严格清洗数据,剔除错误、重复及噪声。

- 数据格式化: 将数据整理为模型所需格式(如JSONL),文本任务常用指令格式:

{"instruction": "将以下句子翻译成英文", "input": "今天天气真好", "output": "The weather is very nice today."}

-

搭建训练环境:

- 硬件基础: GPU是加速训练的核心,NVIDIA显卡搭配CUDA是主流选择,云端平台(Google Colab, Lambda Labs)提供灵活算力。

- 软件栈配置: 安装Python、深度学习框架(PyTorch/TensorFlow)、模型训练库(如Hugging Face Transformers, PyTorch Lightning),容器化(Docker)能确保环境一致性。

-

模型加载与预处理:

- 使用Transformers库轻松加载预训练模型和分词器:

from transformers import AutoModelForCausalLM, AutoTokenizer model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b-chat-hf") tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-2-7b-chat-hf") - 数据转换: 用分词器将文本转为模型可读的数字ID(Token),并生成注意力掩码等。

- 使用Transformers库轻松加载预训练模型和分词器:

-

选择高效训练策略:

- 全参数微调: 更新模型所有权重,效果显著但资源消耗巨大,适用于充足算力及特定领域深度适配。

- 高效微调技术(PEFT): 资源有限时的首选:

- LoRA (Low-Rank Adaptation): 在原始权重旁添加小型可训练矩阵,大幅减少参数量(可节省70%以上显存)。

- QLoRA: 在LoRA基础上引入模型量化(如4-bit),进一步降低显存需求,使得大模型在消费级显卡上训练成为可能。

- 工具简化: Hugging Face PEFT库、Axolotl等工具极大简化了LoRA/QLoRA的实现。

-

配置与启动训练:

- 超参数设定: 调整学习率(常取较小值如2e-5)、批次大小(受限于显存)、训练轮次(防止过拟合)。

- 选择优化器: AdamW是当前主流选择。

- 使用训练器: Transformers的Trainer或第三方框架(如DeepSpeed优化分布式训练)封装了训练循环、日志记录和保存点,核心代码框架:

from transformers import TrainingArguments, Trainer training_args = TrainingArguments( output_dir="./results", num_train_epochs=3, per_device_train_batch_size=4, learning_rate=2e-5, ... # 其他参数 ) trainer = Trainer( model=model, args=training_args, train_dataset=tokenized_train_dataset, ... # 可加入评估数据集 ) trainer.train() # 启动训练!

-

监控、评估与保存:

- 实时监控: 关注损失值下降、资源占用(GPU显存、利用率),TensorBoard等工具可视化训练过程。

- 效果评估: 在预留的验证集上测试模型表现,文本生成常用BLEU、ROUGE;分类任务看准确率/F1值,人工评估生成结果的质量至关重要。

- 模型保存: 训练完成后,保存完整模型或适配器(如LoRA权重),Hugging Face模型库方便共享与部署。

-

部署与应用:

- 推理接口: 使用Transformers的pipeline快速测试:

from transformers import pipeline generator = pipeline("text-generation", model="./my_finetuned_model") print(generator("请解释一下机器学习。")[0]['generated_text']) - 部署选项: 轻量级API服务(FastAPI + Transformers)、云平台AI服务、本地应用集成,注意优化推理速度(量化、模型编译)。

- 推理接口: 使用Transformers的pipeline快速测试:

关键挑战与实用技巧

- 显存瓶颈: 采用梯度累积(模拟更大批次)、混合精度训练(FP16)、QLoRA、优化器状态卸载(DeepSpeed Zero-3)等技术突破限制,若资源不足,云端训练是务实选择。

- 数据质量陷阱: 低质数据导致模型表现不佳,严格清洗、人工审核、数据增强(如回译)是提升质量的关键,数据标注的成本与质量平衡是长期课题。

- 过拟合风险: 监控验证集表现,适时早停(Early Stopping)、加入Dropout层或调整正则化强度。

- 超参数调优: 初始学习率、批次大小影响巨大,可从小规模实验开始,或利用自动化工具(如Optuna)搜索。

- 硬件配置参考:

- 微调7B模型:QLoRA + 24G显存(如RTX 3090/4090)可应对。

- 微调13B模型:QLoRA通常需要40G以上显存(如A100 40G)。

- 全参数微调:对硬件要求极为苛刻,通常需多张高端GPU。

开源协作:AI发展的核心驱动力 开源生态的价值远超代码本身,它构建了全球开发者协作创新的网络,在Hugging Face等平台上共享数据集、模型权重、训练技巧,每一次分享都在推动技术边界的前移,训练开源模型不仅是技术实践,更是参与塑造AI未来的过程。

当你在自己的设备上启动训练脚本,看着损失曲线缓缓下降,这过程如同现代“炼丹”,每一次尝试,无论成功或挫折,都在深化对智能本质的理解,开源赋予我们探索的钥匙,而训练过程的挑战,恰恰是掌握这项变革性技术必须跨越的门槛——真正的掌握,始于动手实践的那一刻。

探索开源模型训练的过程中,最大的障碍往往不是技术本身,而是迈出第一步的决心,当你亲手调整第一个参数、解决第一次显存溢出错误,技术的神秘面纱便悄然揭开,留下的是一种实实在在的掌控感——这或许才是开源精神最珍贵的馈赠。