在探索人工智能技术时,许多人会好奇:强大的AI模型是如何借助显卡发挥全部潜能的?这个过程并非神秘莫测,而是建立在一套精密的软硬件协作机制之上。

显卡为何成为AI计算的基石

传统中央处理器(CPU)设计用于处理各种复杂任务,擅长逻辑判断和串行计算,但当面对AI模型训练和推理中海量的矩阵运算、浮点计算时,CPU就显得力不从心了,显卡,特别是现代GPU,则采用了截然不同的设计哲学。

GPU拥有数千个计算核心,虽然每个核心相对简单,但大量核心能同时处理相似的计算任务,这种“单指令多数据流”架构特别适合AI工作负载中高度并行的运算需求,想象一下,CPU像是一位学识渊博的教授,能解决各种复杂问题但每次只能处理一个;而GPU则如同千军万马,能同时对大量简单问题发起进攻。

从代码到硬件:AI调用显卡的完整流程

当开发者使用流行的AI框架如TensorFlow或PyTorch编写代码时,表面上只是调用了几行简单的API,底层却发生了一系列复杂的交互过程。

AI框架会将开发者用Python等语言编写的模型定义和运算,转换为高效的底层操作,这些操作通过CUDA(针对NVIDIA显卡)或ROCm(针对AMD显卡)等并行计算平台,被进一步编译成显卡能够理解的指令。

这些指令通过驱动程序传递给显卡,显卡接收到指令后,会分配其内部的计算核心和内存资源,将大规模计算任务分解成小块,分发给数千个核心同时处理,这个过程中,显卡的专用显存扮演着关键角色,它负责存储模型参数、输入数据和中间计算结果,其高带宽特性确保了数据能快速供给计算核心。

值得一提的是现代显卡的Tensor Core或Matrix Core技术,这些专用硬件单元针对矩阵运算进行了特殊优化,能极大提升常见AI运算如卷积、矩阵乘法的速度。

搭建高效的AI计算环境

要让AI模型充分发挥显卡性能,需要从多个层面进行优化:

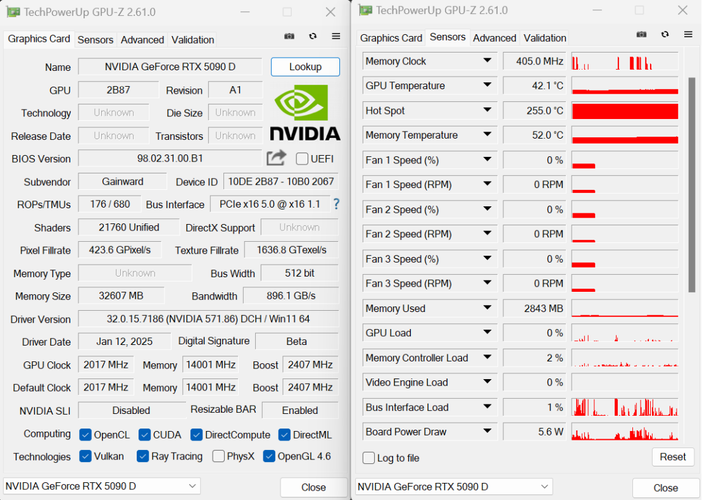

硬件选择方面,显存容量直接决定了能加载的模型大小,对于大型语言模型或高分辨率图像模型,通常需要显存超过10GB的显卡,显存带宽则影响了数据吞吐速度,高带宽允许更快的数据传输,避免计算核心因等待数据而闲置。

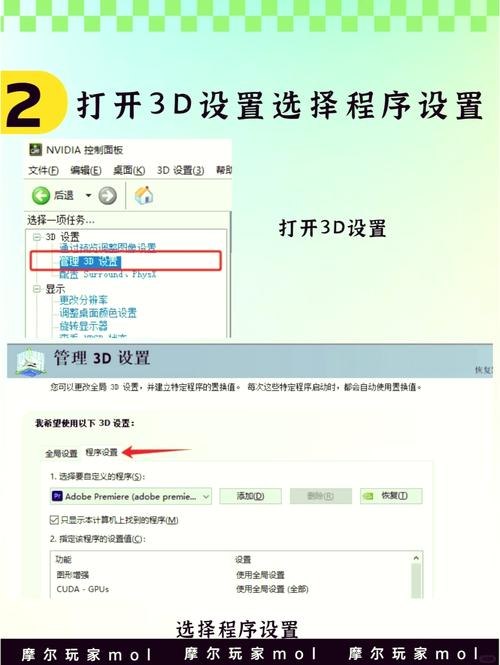

软件环境配置同样关键,正确安装显卡驱动程序、CUDA工具包和AI框架的GPU版本是基础,不同版本的组件之间存在兼容性要求,版本不匹配是导致性能问题或运行失败的常见原因。

在模型开发阶段,开发者可以通过多种技术优化显卡利用率,调整批量大小(batch size)可以在显存容量和计算效率间找到平衡点;使用混合精度训练,即同时使用FP16和FP32浮点数格式,既能减少显存占用又能加速计算;操作融合技术则将多个计算步骤合并为一个内核,减少内存访问次数。

常见挑战与解决思路

实践中,AI开发者常会遇到显卡利用率不高的问题,这可能是由于数据预处理速度跟不上模型计算速度,导致显卡经常处于空闲等待状态,解决方案包括使用多进程数据加载、预加载数据到内存或使用更快的存储设备。

另一个常见问题是显存不足,尤其是在处理大模型或大尺寸输入时,除了升级硬件,还可以采用梯度累积、模型并行、激活检查点等技术来降低显存需求。

随着技术发展,调用显卡的方式也在不断简化,许多云服务平台提供了预配置的AI计算环境,用户无需手动安装驱动和依赖库,高阶API和自动化工具的出现,也让开发者能更专注于模型设计,而不必过度纠结于底层优化。

个人观点

显卡与AI的结合代表了专用硬件加速通用计算的典范,这种协同进化不仅推动了AI技术的快速发展,也重新定义了计算架构的未来方向,理解这一过程,不仅能帮助开发者构建更高效的AI系统,也有助于我们预见下一代计算平台的形态,随着AI模型复杂度的不断提升,软硬件协同设计的重要性只会愈加凸显,而对显卡计算原理的深入理解,将成为AI开发者工具箱中的必备技能。