在当今快速发展的人工智能领域,AI模型的效果直接决定了应用的成败,无论是图像识别、自然语言处理还是推荐系统,提升模型性能都是开发者和研究者的核心目标,本文将从多个角度探讨如何有效增强AI模型的效果,结合实践经验和行业趋势,提供实用的指导。

数据是AI模型的基石,数据质量直接影响模型的泛化能力,确保数据集的多样性和代表性至关重要,收集数据时,应覆盖不同场景和边缘案例,避免偏差导致模型在现实世界中失效,在训练图像分类模型时,如果数据只包含特定光照条件下的图片,模型可能无法处理夜间或低光环境,数据清洗和预处理是必不可少的步骤,去除噪声数据、处理缺失值以及标准化输入特征,能显著提高模型的稳定性和准确性,常用的技术包括数据增强,如旋转、裁剪或颜色变换,这能有效扩充数据集规模,防止过拟合,标注数据的准确性也不容忽视;错误标签会误导模型学习,因此建议采用多人标注和交叉验证来保证质量。

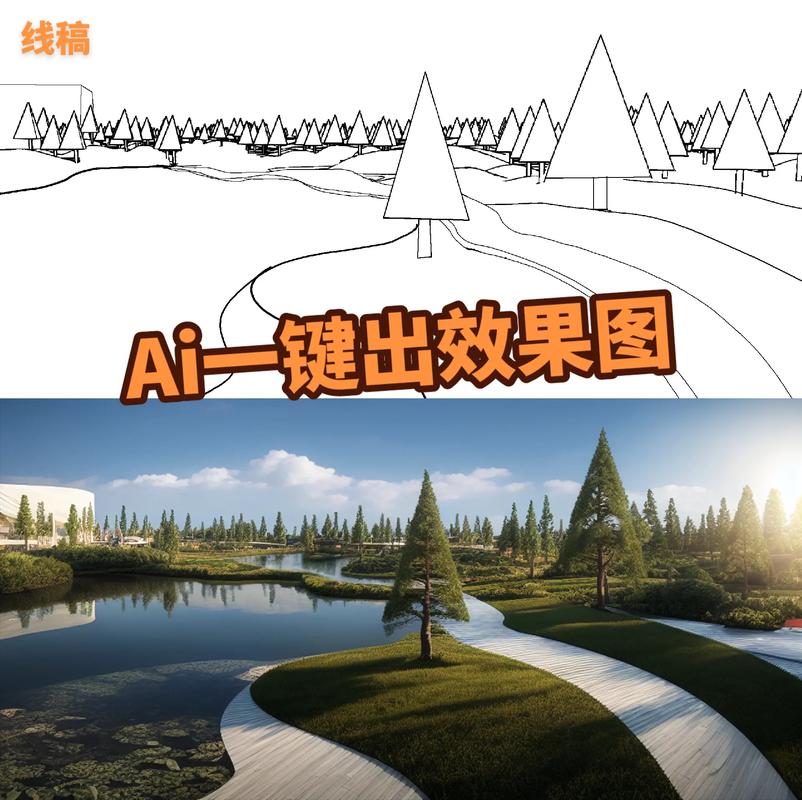

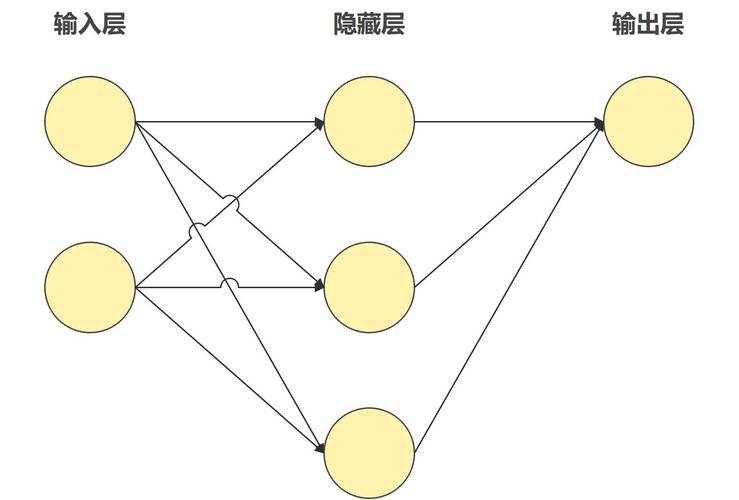

模型架构的选择对性能有深远影响,随着深度学习的发展,各种预训练模型和定制架构层出不穷,在自然语言处理任务中,Transformer架构因其高效的注意力机制而广受欢迎;而在计算机视觉领域,卷积神经网络(CNN)和视觉Transformer(VISION Transformer)各有优势,选择合适的架构需要考虑具体应用场景:如果任务涉及序列数据,循环神经网络(RNN)或长短期记忆网络(LSTM)可能更合适;而对于高分辨率图像,深度卷积网络能捕捉更多细节,迁移学习是一种高效的方法,通过微调预训练模型,可以快速适应新任务,节省计算资源,使用在大型语料库上训练的BERT模型,只需少量数据就能在特定领域实现优异表现。

超参数调优是优化模型效果的关键环节,超参数包括学习率、批量大小、层数和激活函数等,它们控制着训练过程的行为,网格搜索或随机搜索是传统方法,但计算成本较高;更高效的方式是使用贝叶斯优化或自动化工具如Hyperopt,这些方法能智能探索参数空间,找到最优组合,学习率调度尤为重要,动态调整学习率可以避免训练陷入局部最优,余弦退火或周期性学习率策略能帮助模型跳出平稳点,提升收敛速度,正则化技术如Dropout和权重衰减能防止过拟合,确保模型在测试集上表现稳健,实践中,建议从小规模实验开始,逐步扩展,以平衡时间和资源投入。

训练过程的优化同样不可忽视,分布式训练和混合精度计算能加速模型迭代,尤其在大规模数据集上,使用GPU或TPU集群可以并行处理数据,缩短训练时间,监控训练过程中的指标,如损失函数和准确率,有助于及时发现问题,早停法(Early Stopping)是一种实用技巧,当验证集性能不再提升时停止训练,避免资源浪费,另一个重要方面是损失函数的设计;根据任务特性定制损失函数,例如在分类问题中使用Focal Loss处理类别不平衡,或在回归任务中采用Huber Loss增强鲁棒性,集成学习通过组合多个模型的预测,能显著提升最终效果,例如Bagging或Boosting方法在竞赛中屡试不爽。

模型评估和部署后的持续优化是保证长期效果的核心,在评估阶段,除了准确率,还应关注精确率、召回率和F1分数等指标,以全面衡量模型性能,交叉验证和A/B测试能提供更可靠的反馈,尤其是在真实环境中,部署后,模型可能会遇到数据漂移或概念漂移问题,导致性能下降,建立监控机制,定期用新数据重新训练模型,是维持效果的必要措施,在线学习或增量学习技术允许模型动态适应变化,无需从头开始训练,解释性工具如SHAP或LIME能帮助理解模型决策,增强可信度,这在医疗或金融等高风险领域尤为重要。

从个人观点来看,提升AI模型效果不仅依赖技术手段,更需要一种系统性思维,数据、模型和流程的紧密结合,才能实现可持续的改进,随着自适应学习和元学习等前沿技术的发展,AI模型将更智能地自我优化,但核心仍在于以人为本的设计——关注用户需求和社会影响,避免盲目追求指标,通过持续学习和实践,我们能在AI浪潮中保持领先,创造真正有价值的解决方案。