在数字化进程不断加速的今天,人工智能技术逐渐渗透到各行各业,许多企业和开发者希望将AI模型部署到本地服务器或设备上,以提升数据处理效率、保障隐私安全或满足特定业务需求,本文将系统介绍本地部署AI模型的核心流程与注意事项,帮助读者掌握从理论到实践的关键步骤。

理解本地部署的核心价值

本地部署AI模型指将训练好的算法完全运行在自有硬件环境中,而非依赖云端服务,这种模式适用于对数据隐私要求严格的场景(如医疗、金融领域),或需要实时响应、网络条件受限的项目,相较于云端部署,本地化能有效减少延迟,降低长期使用成本,同时赋予用户更高的控制权,例如灵活调整模型参数或二次开发。

部署前的准备工作

-

硬件环境评估

根据模型复杂度选择适配的硬件,基于Transformer架构的大语言模型通常需要高性能GPU(如NVIDIA A100)支持;轻量级图像分类模型则可在配备TensorCore的消费级显卡(如RTX 30/40系列)上运行,需特别关注显存容量与模型参数量的匹配关系——显存不足会导致推理中断。 -

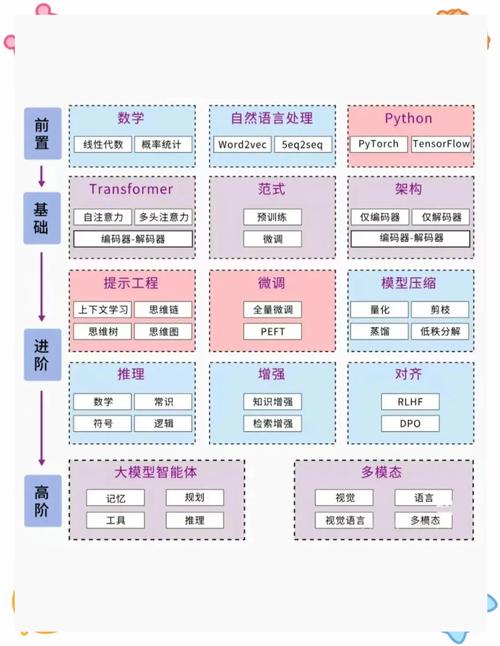

软件框架选择

主流的深度学习框架包括TensorFlow、PyTorch和ONNX Runtime,若追求部署效率,可考虑专用推理引擎如TensorRT或OpenVINO,这类工具能通过算子融合、量化压缩等技术显著提升运行速度,使用TensorRT可将ResNet-50的推理速度提高3倍以上。

-

模型格式转换

训练完成的模型需转换为部署环境兼容的格式,PyTorch模型通常导出为TorchScript或ONNX格式,TensorFlow模型则保存为SavedModel或转换为TFLite(移动端场景),跨平台部署时,建议使用ONNX作为中间表示,因其支持多数框架的互操作性。

分步实现部署流程

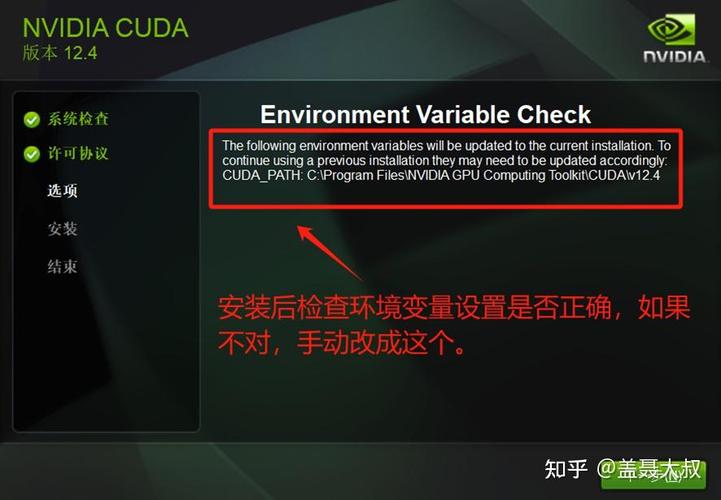

步骤1:搭建基础环境

安装CUDA工具包(11.8以上版本)和对应版本的cuDNN库,对于Python环境,推荐使用conda创建虚拟环境,避免依赖冲突,关键包包括:

conda install pytorch torchvision torchaudio cudatoolkit=11.8 -c pytorch pip install onnxruntime-gpu

步骤2:模型优化处理

通过剪枝、量化等技术压缩模型规模,以PyTorch为例,可使用官方提供的Quantization API进行动态量化:

model = torch.quantization.quantize_dynamic(

model, {torch.nn.Linear}, dtype=torch.qint8

)

此操作可使模型体积缩小至原版的1/4,同时保持90%以上的精度。

步骤3:编写推理接口

构建Flask或FastAPI服务封装模型,以下为FastAPI的示例代码:

from fastapi import FastAPI

app = FastAPI()

@app.post("/predict")

async def predict(input_data: dict):

tensor_input = preprocess(input_data)

with torch.no_grad():

output = model(tensor_input)

return {"result": postprocess(output)}

步骤4:压力测试与监控

使用Locust或JMeter模拟高并发请求,监测显存占用、响应时间等指标,建议设置熔断机制,当显存使用率超过80%时自动拒绝新请求,防止系统崩溃。

持续优化策略

-

硬件加速技术应用

启用NVIDIA的TensorRT加速库,利用FP16精度混合计算提升吞吐量,对于Intel处理器,可使用OpenVINO进行指令集优化,在CPU上实现接近GPU的性能表现。 -

容器化部署方案

采用Docker封装模型与环境依赖,确保跨平台一致性,结合Kubernetes可实现自动扩缩容,例如设置HPA(Horizontal Pod Autoscaler)根据GPU利用率动态调整实例数量。 -

安全防护机制

在API网关层添加身份验证(OAuth2.0/JWT),对输入数据进行严格过滤,防止对抗样本攻击,定期更新依赖库版本,修补CVE披露的安全漏洞。

常见问题解决方案

- 显存不足报错:启用梯度检查点技术,以时间换空间;或使用模型并行将不同层分配到多个GPU

- 推理速度慢:转换为TensorRT引擎,启用CUDA Graph优化内核启动开销

- 框架兼容性问题:使用ONNX进行格式中转,必要时自定义插件实现特殊算子

将AI模型成功部署到本地环境需要技术积累与实践经验的双重支撑,随着边缘计算设备的性能提升,本地化部署正在成为平衡效率与安全的最佳选择,对于中小型企业,初期可优先部署轻量化模型,逐步积累技术能力;大型机构则应建立完整的MLOps体系,实现模型全生命周期管理,技术的价值最终体现在业务场景的落地效果,选择合适的部署策略,方能最大化AI赋能的实际效益。