从零开始运行AI大模型的完整指南

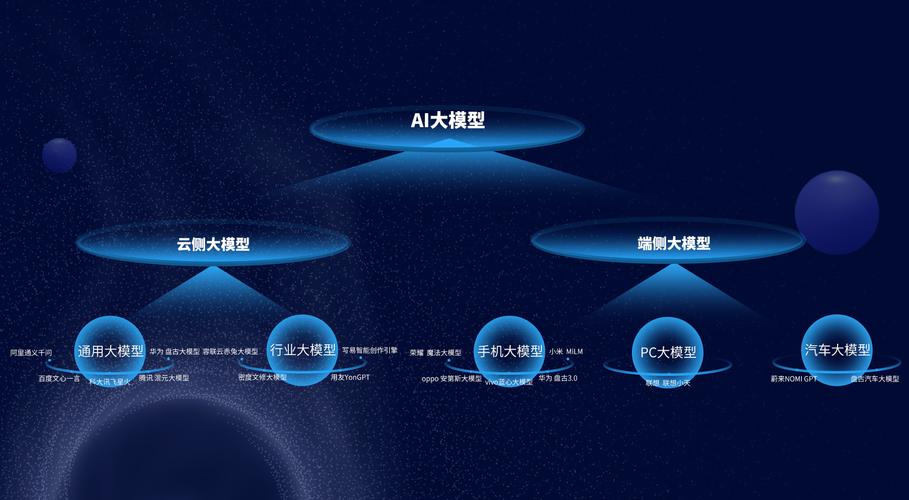

近年来,AI大模型的应用场景越来越广,从文本生成到图像处理,从数据分析到自动化决策,许多人对如何亲自运行这类模型产生了兴趣,但面对动辄数十亿参数的大模型,许多人可能感到无从下手,本文将以实用为导向,一步步拆解运行AI大模型的核心流程,帮助普通人快速入门。

入门前的关键准备

运行AI大模型并非“下载即用”,需要明确三个核心问题:硬件条件、技术目标、学习成本。

-

硬件资源评估

- 显存需求:多数大模型需要GPU支持,显存至少12GB起步(如NVIDIA RTX 3060以上),显存不足时,可尝试量化技术(如8-bit加载)或使用云端资源(如Google Colab)。

- 存储空间:模型文件通常占用几十GB空间,建议预留200GB以上的硬盘容量。

-

明确技术目标

- 任务类型:文本生成、代码补全、图像生成等不同任务对应不同的模型架构(如GPT、Stable Diffusion)。

- 模型规模:并非参数越大越好,7B参数的模型适合本地调试,175B参数的模型需依赖分布式计算。

-

学习成本规划

熟悉Python基础语法与PyTorch/TensorFlow框架是必要条件,若零基础,建议预留1-2周学习时间。

环境搭建:从本地到云端的三种方案

根据硬件条件,可选择以下路径部署环境:

方案1:本地部署(适合中高配显卡用户)

- 安装CUDA工具包:确保GPU驱动与框架版本匹配(如PyTorch 2.0+需CUDA 11.8)。

- 使用Hugging Face生态:通过

transformers库快速调用预训练模型,一行代码加载Llama 2或GPT-Neo:from transformers import AutoModelForCausalLM model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b")

方案2:云端租赁(适合短期实验)

- 推荐平台:Google Colab(免费版提供T4 GPU)、AWS SageMaker(按需计费)。

- 优势:无需维护硬件,可直接在Jupyter Notebook中运行代码。

方案3:分布式训练(适合企业级需求)

- 工具链:DeepSpeed、Megatron-LM等框架支持多卡并行,但需掌握分布式训练原理。

模型选择与训练:平衡效率与效果

模型下载与微调

- 主流开源模型:

- 文本生成:Llama 2、Falcon-40B

- 代码生成:CodeLlama、StarCoder

- 多模态:OpenFlamingo、MiniGPT-4

- 微调方法:

- 全参数训练:效果最佳,但显存需求极高。

- LoRA(低秩适应):仅训练新增的低秩矩阵,显存占用降低70%。

数据准备技巧

- 格式要求:文本类模型需将数据整理为

.txt或.jsonl格式,每行包含单条样本。 - 数据量参考:微调7B模型至少需要1万条高质量数据。

训练代码示例(以Hugging Face为例)

from transformers import Trainer, TrainingArguments

training_args = TrainingArguments(

output_dir="./results",

per_device_train_batch_size=4,

num_train_epochs=3,

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=dataset

)

trainer.train()

避坑指南:常见问题与优化策略

-

显存不足的解决方案

- 启用梯度检查点:

model.gradient_checkpointing_enable() - 混合精度训练:在TrainingArguments中设置

fp16=True

- 启用梯度检查点:

-

推理速度优化

- 使用量化模型:将32位浮点权重转为8位整数(需安装

bitsandbytes库)。 - 启用缓存机制:通过

past_key_values重复利用已计算的注意力结果。

- 使用量化模型:将32位浮点权重转为8位整数(需安装

-

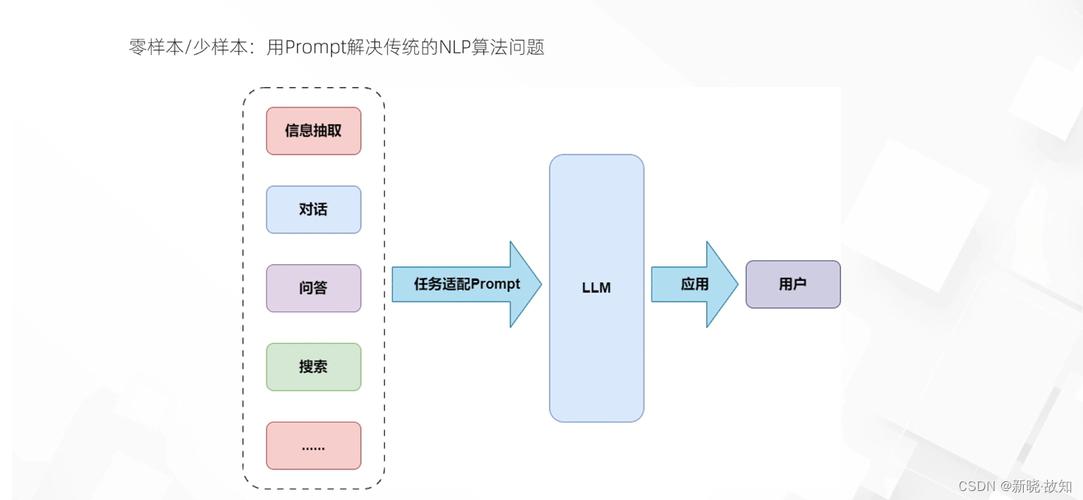

模型效果调优

- 控制生成结果:调整

temperature(创造性)和top_p(多样性)参数。 - 添加提示词(Prompt Engineering):通过模板引导模型输出更符合预期的内容。

- 控制生成结果:调整

风险与责任:不可忽视的伦理问题

尽管技术门槛逐渐降低,但运行大模型需警惕以下风险:

- 版权风险:部分开源模型限制商用(如Llama 2需申请Meta许可)。

- 数据隐私:避免在训练数据中混入个人信息或敏感内容。

- 算力消耗:单次训练7B模型的碳排放量相当于一辆汽车行驶400公里。

个人观点

运行AI大模型的过程就像组装一台精密仪器,既需要耐心调试硬件环境,也要理解模型的内在逻辑,对于初学者,建议从7B以下参数量的模型入手,逐步积累调参和优化的经验,技术本身是中性的,但如何用它创造价值,取决于使用者的目标与边界感,与其追逐“更大更强”的模型,不如先思考:这项技术真正能解决我的什么问题?