离线翻译AI模型使用指南:解锁无网络的语言自由

想象一下:身处异国他乡的偏远小镇,手机信号微弱,却急需理解路牌上的关键信息;或是在处理包含敏感商业数据的文档,对云端翻译心存顾虑,离线翻译AI模型便是您最可靠的语言伙伴,这类技术将强大的翻译引擎完整封装在您的设备中,无需依赖互联网,即可实现快速、私密的跨语言沟通。

第一步:获取与部署离线翻译模型

-

选择合适的模型: 这是关键起点,市场上有多种选择:

- 开源模型: 如 Facebook 的 M2M-100、Bergamot(由 Mozilla 等推动)、OpenNMT 项目模型等,这些模型通常免费,灵活性高,但部署可能需要一定技术基础,可在 Hugging Face Hub、GitHub 等平台查找。

- 商业/开发者SDK: 如 Google ML Kit 翻译、Amazon Translate Device SDK、微软 Azure 认知服务容器等,它们通常提供优化过的预编译模型和易用的 API,但可能有授权费用或使用限制。

- 集成离线功能的翻译应用: 如 Google 翻译(部分语言包)、iTranslate、DeepL(特定订阅计划)等,这是对普通用户最友好的方式,只需在应用内下载所需语言包即可。

-

准备运行环境:

- 硬件: 确保您的设备(手机、平板、电脑甚至某些专用硬件)满足模型运行的最低要求,尤其是内存(RAM)和存储空间,大型模型可能需要数 GB 空间和充足内存。

- 软件框架: 如果您部署的是开源模型,通常需要安装相应的机器学习框架运行时环境,常见的有:

- PyTorch Mobile / LibTorch: 适用于 PyTorch 模型。

- TensorFlow Lite: Google 推出的轻量级框架,广泛用于移动和嵌入式设备,支持多种模型格式转换。

- ONNX Runtime: 支持开放神经网络交换格式,兼容多种框架导出的模型。

- 依赖库: 模型运行可能还需要其他库支持,如 NumPy、特定 tokenizer 等。

-

模型安装与集成:

- 对于应用用户: 在支持的翻译应用中,进入设置或语言管理,查找“离线翻译”或“下载语言包”选项,选择您需要的目标语言对,等待下载完成,通常只需点击几次即可完成。

- 对于开发者/技术用户:

- 将下载的模型文件(如

.tflite,.ptl,.onnx或.bin等格式)放入项目指定目录。 - 在您的代码中(如 Python, Java, C++, Swift, Kotlin 等)集成所选框架的推理 API。

- 编写代码加载模型、预处理输入文本(分词、编码)、执行翻译推理、后处理输出文本(解码、组合)。

- 将其封装成函数或服务供调用。

- 将下载的模型文件(如

第二步:实际使用离线翻译功能

-

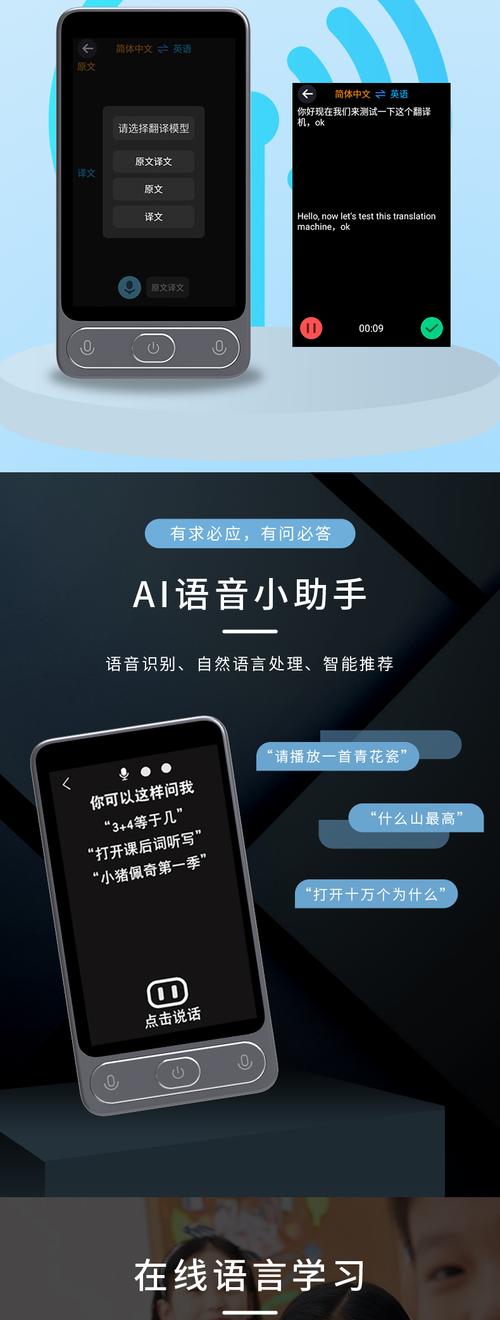

启动与选择: 打开您部署好离线模型的应用或自研工具,确保界面或设置中已指明当前处于“离线模式”或已激活离线翻译功能,选择您需要翻译的源语言和目标语言(英语 -> 中文)。

-

输入文本:

- 文本输入框: 最常见的交互方式,直接在应用或工具的输入框中键入或粘贴需要翻译的文本内容。

- 语音输入(如支持): 部分集成离线语音识别的应用允许您直接说话,语音被识别为文本后再送入离线翻译引擎。

- 相机取词/OCR(如支持): 高级应用可能集成离线 OCR 功能,将摄像头对准外文文本(如菜单、路牌、文档),应用识别出文字后自动送入离线翻译引擎处理。

-

执行翻译: 点击“翻译”按钮(或触发相应操作),翻译过程完全在您的设备内部进行:

- 输入的文本被模型的分词器处理成模型理解的数字序列(Token)。

- 模型(通常是 Encoder-Decoder 结构的神经网络)根据输入的序列,逐词或逐子词预测生成目标语言的序列。

- 生成的序列被解码器转换回人类可读的目标语言文本。

-

查看结果: 翻译结果几乎瞬间(取决于模型大小和设备性能)显示在输出框中,您可以阅读、复制或使用翻译后的文本。

优化体验与注意事项

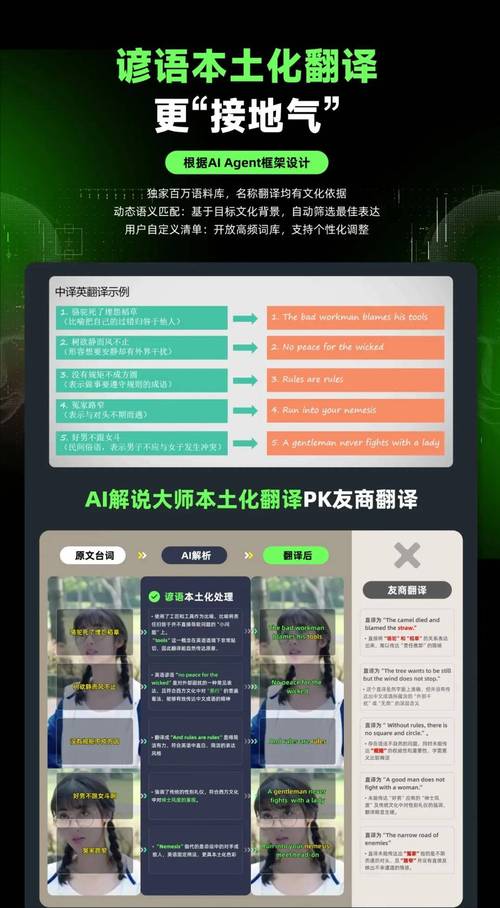

- 模型质量: 离线模型为了追求速度和体积,精度通常略低于其庞大的云端版本,对翻译质量有极高要求时需留意,选择时关注模型在目标语言对上的评测结果(如 BLEU 分数)。

- 语言对覆盖: 并非所有语言组合都有高质量的离线模型可用,主流的英<->中、英<->西、英<->法等通常支持较好,小语种或稀有语对可能选择有限。

- 存储管理: 离线语言包体积可观,定期清理不再需要的语言包以释放设备空间。

- 更新模型: 语言在变化,模型也在迭代,关注应用更新或开源模型的新版本发布,及时获取更优的翻译效果和性能。

- 性能考量: 首次加载模型或翻译长文本时可能有短暂延迟,复杂模型在低端设备上可能运行缓慢或耗电增加,考虑模型量化技术(降低精度以换取速度和体积优化)。

- 隐私安全: 离线翻译的核心优势是数据不离设备,对于处理敏感信息的场景,务必确认所选方案确实在本地完成所有计算,无数据外传风险,验证开源模型代码或信誉良好商业 SDK 的隐私声明。

个人观点

离线翻译AI模型绝非简单的技术降级,而是将人工智能能力真正赋予个体掌控权的实践,它打破了网络束缚,为旅行者、跨国工作者、隐私敏感人士乃至整个数字包容性运动提供了关键解决方案,尽管在模型精度和覆盖广度上仍有提升空间,但其带来的即时性、安全性和可靠性是云端服务难以替代的,随着边缘计算硬件持续进化,模型小型化技术不断突破,离线翻译的体验只会越来越流畅自然,离线与在线翻译将更深度融合,但离线模型作为保障基本语言沟通权利和核心隐私的基石,其价值只会愈发凸显——真正强大的工具,应能在任何环境下,包括完全离线时,依然为我们效力。