人工智能模型训练是一个系统化且充满创造力的过程,它并非一蹴而就的魔法,而更像是一位艺术家教导学徒识别万千世界,本文将以“图片”这一直观载体为例,为您清晰地拆解AI模型训练的核心步骤与理念。

第一步:奠定基石——高质量数据的准备

任何卓越AI模型的起点,都是优质的数据,对于图片模型而言,数据就是经过精心筛选和标注的图像集合。

- 数据收集: 我们需要围绕目标收集大量图片,要训练一个识别猫的模型,就需要收集成千上万张包含不同品种、姿态、光照环境和背景的猫的图片,为了提升模型的泛化能力,避免其产生偏见,还需收集“非猫”(如狗、汽车、树木等)的图片作为负样本。

- 数据清洗与标注: 收集的原始数据往往是粗糙的,需要清洗,剔除模糊、不相关或重复的图片,随后是最关键的一步——数据标注,这意味着需要人工为每张图片打上标签,在猫的图片上标注“猫”,在狗的图片上标注“狗”,对于更复杂的任务(如物体检测),还需要用边界框精确框出图片中猫的位置,数据的质量和标注的准确性直接决定了模型能力的天花板,所谓“垃圾进,垃圾出”,正是这个道理。

第二步:构建框架——模型的选择与设计

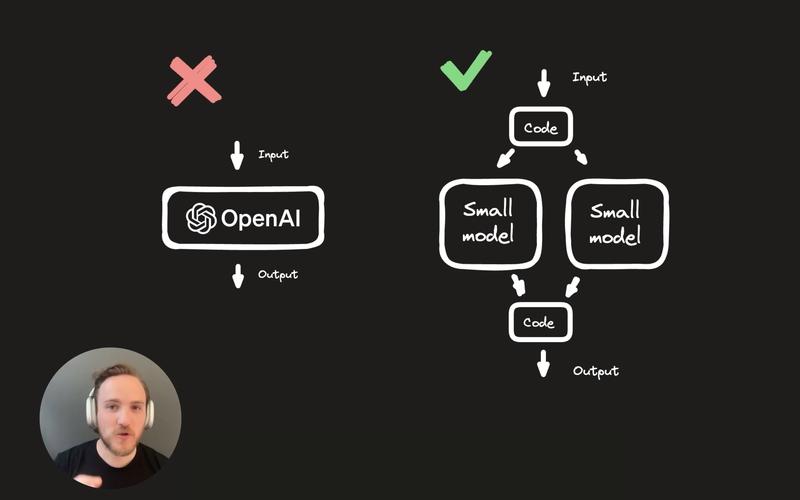

有了数据,我们需要一个能够从数据中学习的“大脑”,即模型结构,幸运的是,我们不必每次都从零开始。

- 选择架构: 对于图像识别任务,卷积神经网络(CNN)是目前最主流且高效的架构,它的设计灵感来源于人类视觉皮层,能高效提取图片中的空间层次特征(如边缘、纹理、形状)。

- 利用预训练模型: 在实践中,许多开发者和研究者会采用“迁移学习”的策略,他们选择一个在超大规模数据集(如ImageNet)上预训练好的成熟模型(如ResNet, VGG, EfficientNet等),这个模型已经学会了识别大量通用特征,我们只需在其基础上,针对自己特定的任务(例如专门识别特定品种的猫)进行微调(Fine-tuning),这极大地降低了计算成本和时间,让小规模团队也能训练出高性能模型。

第三步:教导与学习——模型的训练过程

这是将数据和模型结合,让模型真正“学”起来的核心环节。

- 初始化与喂食: 模型内部的参数(可以理解为神经元的连接强度)会被随机初始化,随后,我们将准备好的标注图片一批一批地“喂”给模型。

- 前向传播与计算损失: 模型对输入的图片进行处理和分析,并输出一个预测结果(它认为图片中有82%的概率是猫),系统会将这个预测结果与真实的标签(100%是猫)进行对比,通过一个称为“损失函数”的公式计算出预测的误差有多大。

- 反向传播与参数优化: 计算出误差后,这个误差信号会沿着网络反向传播回去,一个名为“优化器”(如Adam、SGD)的算法会根据误差大小,自动地调整模型内部数百万甚至数十亿的参数,目的是让下一次预测的误差更小。

这个过程循环往复成千上万次,模型在每一次迭代中都会根据错误进行微调,其预测能力也随之变得越来越精准,损失值逐渐降低。

第四步:检验与优化——模型的评估与调参

训练过程中的模型表现并不能代表其真实能力,它可能只是“记住了”训练数据(过拟合)。

- 划分数据集: 我们最初就会将数据分为三部分:训练集(用于学习)、验证集(用于在训练过程中评估模型表现,并调整超参数)和测试集(用于最终模拟真实场景,测试模型的泛化能力)。

- 评估指标: 我们会使用验证集和测试集来评估模型,常用指标包括准确率、精确率、召回率等,如果模型在训练集上表现优异,却在验证集上表现糟糕,则说明出现了过拟合,需要通过数据增强、 dropout 或简化模型等方法来应对。

- 超参数调优: 学习率、批处理大小等设置(超参数)也需要反复调试,以找到让模型表现最佳的组合,这是一个需要耐心和实验的过程。

训练一个AI图片模型,本质上是将人类的视觉知识,通过数据的形式,“蒸馏”到数学模型中的过程,它既是一门严谨的科学,需要精确的数学和工程实现;也是一门艺术,需要从业者对数据、模型和问题本质有深刻的理解和直觉,每一次成功的训练,都是人类智能与机器计算能力之间一次完美的协作。