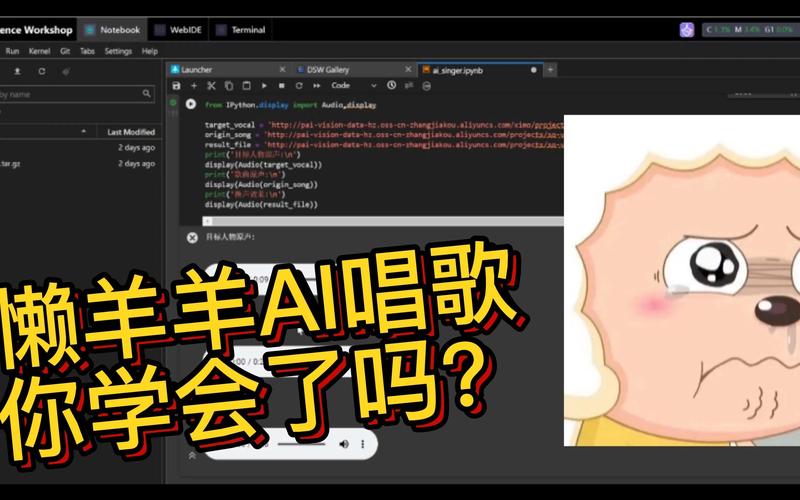

在人工智能技术快速发展的今天,AI模型已能够模拟人类声音并演唱歌曲,无论是音乐创作、虚拟歌手开发,还是语音交互场景的优化,声音模型的训练已成为技术领域的热点,以下将从数据准备、模型选择到训练优化,系统讲解如何构建一个能“唱歌”的AI声音模型。

高质量数据:模型的基石

训练AI声音模型的第一步是获取高质量音频数据,数据质量直接影响最终效果,需遵循以下原则:

- 专业人声采集

- 选择音域宽广、发音清晰的歌手或配音演员录制样本,涵盖不同音高、节奏和情感表达。

- 建议录制环境为专业录音棚,避免背景噪音,采样率不低于44.1kHz,位深24bit。

- 多语言与风格覆盖

- 若需支持多语种演唱,需分别采集中文、英文、日文等语言的发音数据。

- 风格多样化:流行、民谣、摇滚等不同曲风需对应不同的发声特点。

- 数据清洗与标注

- 使用工具(如Audacity)去除杂音、爆音,并对音频分段标注歌词、音高、节奏等信息。

- 标注格式推荐JSON或XML,便于后续模型解析。

模型架构:选择适合的算法

当前主流的声音生成模型可分为三大类,各有其适用场景:

- 端到端合成模型(如Tacotron 2)

- 特点:直接将文本转换为频谱,再通过声码器生成音频。

- 优势:生成效果自然,适合长句子演唱。

- 缺点:对数据量和算力要求较高。

- 波形生成模型(如WaveNet、WaveGlow)

- 特点:逐点生成波形,适合高保真音质输出。

- 优势:细节还原度强,适用于情感丰富的演唱。

- 挑战:训练时间较长,需优化并行计算。

- 扩散模型(如DiffWave)

- 特点:通过逐步去噪生成音频,稳定性较高。

- 适用场景:需要高可控性的音乐风格迁移。

建议初学者从Tacotron 2+WaveGlow的组合入手,社区支持完善且效果平衡。

训练流程:关键步骤解析

- 数据预处理

- 将音频转换为梅尔频谱图,作为模型输入。

- 使用音高提取工具(如CREPE)标注每帧基频(F0),供模型学习音高变化。

- 超参数设置

- 初始学习率设为0.001,采用余弦退火策略。

- Batch size根据显存调整(建议不低于16),训练步数通常需10万次以上。

- 多阶段训练

- 第一阶段:冻结声码器,单独训练声学模型,确保音素对齐准确。

- 第二阶段:联合微调声学模型与声码器,提升整体自然度。

示例代码(PyTorch框架):

optimizer = AdamW(model.parameters(), lr=0.001, weight_decay=1e-5) scheduler = CosineAnnealingLR(optimizer, T_max=100000)

优化技巧:提升演唱表现力

- 情感控制

在数据标注中加入情感标签(如欢快、悲伤),训练时通过条件向量控制输出风格。

- 呼吸声建模

保留录音中的换气声,并标注其位置,使AI演唱更具真实感。

- 动态范围压缩

在声码器中引入动态压缩算法,避免音量突变导致失真。

- 实时反馈训练

将生成音频输入二次判别网络,构建对抗训练(GAN)框架,优化细节表现。

伦理与版权:不可忽视的边界

- 声音授权

使用歌手录音前需取得书面授权,明确AI生成内容的版权归属。

- 防止滥用

在模型中加入水印技术,标记AI生成内容。

- 用户知情权

商业化应用中需明确告知用户正在使用AI合成声音。