近年来,人工智能在音乐领域的应用逐渐深入,从自动作曲到声音合成,技术不断突破,如何利用AI训练模型实现唱歌功能,成为许多创作者和科技爱好者关注的话题,本文将系统介绍训练AI模型唱歌的核心步骤与注意事项,帮助读者理解技术原理并掌握实践方法。

数据准备:构建高质量音源库

训练AI唱歌模型的第一步是收集并处理优质数据,需要包含以下两类内容:

- 人声音频:选择清晰、无背景噪音的干声素材,涵盖不同音高、音色和演唱风格,建议采集专业歌手或配音演员的录音,时长至少10小时以上。

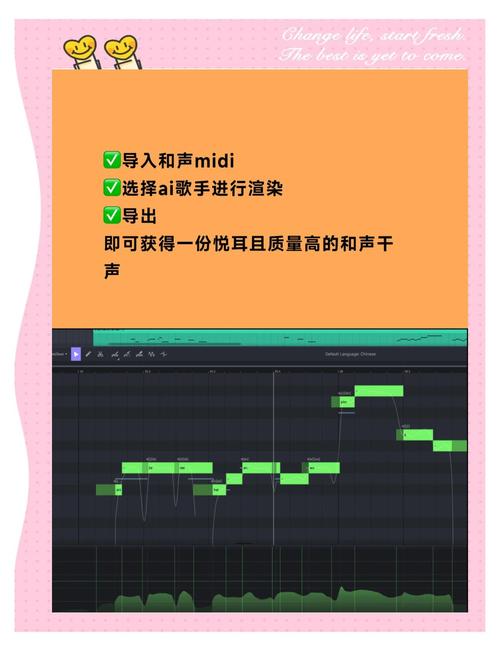

- 对应乐谱:包括歌词文本、音符序列、节奏标记等结构化数据,需与音频精确对齐,可使用MIDI文件或音乐标注软件生成时间轴信息。

处理时需注意采样率统一(推荐48kHz),通过语音分离技术去除伴奏,对破音、呼吸声等细节进行降噪处理,建立完善的元数据标签系统,按音域、语种、情感等维度分类存储。

模型架构选择与搭建

目前主流方案可分为两类:

端到端生成模型

- 使用Transformer或Diffusion模型直接学习音频波形

- 优点:保留演唱细节更完整

- 挑战:需要强大算力支持,训练周期较长

声码器+参数控制方案

- 第一阶段:训练声学模型预测音高、节奏、音色特征

- 第二阶段:通过声码器(如HiFi-GAN)合成波形

- 优势:模块化设计便于调试,资源消耗较低

推荐初学者从So-VITS-SVC、DiffSinger等开源项目入手,这些工具已集成数据处理、特征提取等模块,支持在消费级显卡上运行。

训练过程中的关键调优技巧

- 损失函数设计:结合梅尔频谱重建损失、音高均方误差、节奏对齐度等多维度指标

- 数据增强策略:

- 随机调整音频速度(±10%)

- 添加轻微房间混响

- 对音高进行半音偏移

- 渐进式训练法:

- 先训练基础音色特征

- 逐步加入颤音、气声等细节

- 最后微调情感表达模块

监控训练过程时,要定期生成测试样本,重点检查长音保持、音阶过渡、辅音清晰度等关键指标,当验证集损失连续5个epoch无明显下降时,应考虑停止训练防止过拟合。

生成效果优化方案

模型部署后,可通过以下方式提升输出质量:

- 输入预处理:

- 对用户提供的参考音高进行平滑处理

- 自动修正歌词发音与节奏偏差

- 参数控制:

- 呼吸强度调节滑块(0-1.0)

- 情感强度调节器(平静/激昂)

- 后处理方案:

- 动态均衡器平衡频段能量

- 智能消除齿音与爆音

建议建立多维评价体系,包括MOS主观评分、节奏误差率(RER)、音高准确度(PDA)等量化指标,持续优化模型表现。

伦理与版权考量

开发AI歌唱模型需注意:

- 训练数据需获得权利人明确授权

- 生成作品应标注"AI合成"标识

- 建立声音克隆授权验证机制

- 避免生成侵权或敏感内容

日本JASRAC、美国ASCAP等机构已出台AI音乐版权指引,建议开发者提前进行合规性审查。

AI技术的进步正在重塑音乐创作边界,当我们在实验室听到模型完美演绎歌剧选段时,既惊叹于算法之美,更应思考人类艺术的不可替代性,技术终究是表达工具,真正动人的歌声永远源自对生命的感悟与情感的共鸣,如何在人机协同中找到平衡点,或是这个时代留给所有创作者的核心命题。