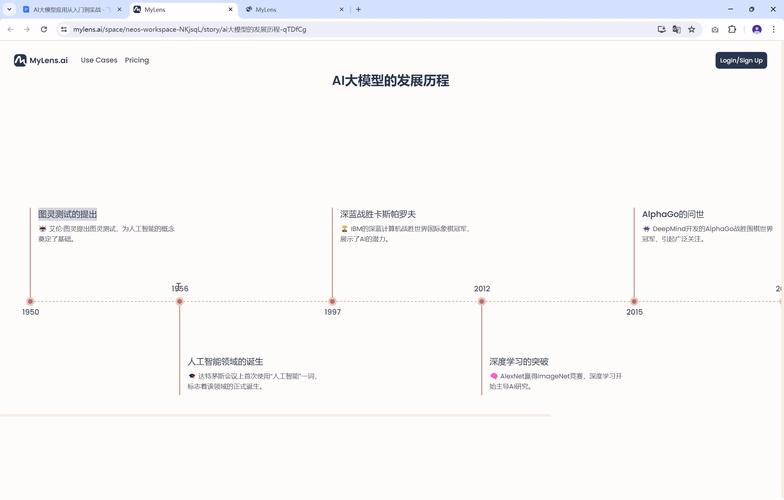

AI模型训练是当今技术领域的核心技能,它能让计算机从数据中学习规律,完成各种智能任务,作为一个长期从事网站开发和AI应用的站长,我经常收到访客询问如何入门训练AI模型,我就以实际经验为基础,分享一个清晰、实用的指南,AI训练不是魔术,而是科学和艺术的结合,需要耐心和实践。

训练AI模型的第一步是数据收集,数据是模型的“燃料”,没有高质量数据,训练效果会大打折扣,你需要确定目标任务,比如图像识别或文本分析,然后收集相关数据集,训练一个猫狗分类模型,可以从公开数据库如ImageNet下载图像,确保数据多样、平衡:如果数据全是猫的图片,模型就学不会识别狗,数据量也很关键——初学者可以从几千条记录开始,但专业项目可能需要数百万条,我建议使用Kaggle或UCI机器学习库,这些资源免费可靠,避免版权问题,收集时,注意隐私和伦理规范,比如去除个人敏感信息,这能提升模型的公信力。

接下来是数据预处理,这一步常被忽视,却直接影响模型表现,原始数据往往杂乱无章:图像可能有噪点,文本包含拼写错误,你需要清洗数据,比如用Python的Pandas库去除重复项、填补缺失值,进行标准化或归一化处理,将数据转换到统一尺度,图像数据可以缩放像素值到0-1范围,文本数据则需分词和向量化,预处理还包括划分数据集:通常将70%用于训练,15%用于验证,15%用于测试,验证集帮助调整参数,测试集评估最终性能,我的经验是,花时间在预处理上能省去后期麻烦——一个干净数据集能让训练过程更顺畅。

选择模型架构是关键决策,AI模型有多种类型,如神经网络、决策树或支持向量机,对于深度学习,卷积神经网络(CNN)适合图像任务,循环神经网络(RNN)处理序列数据如文本,初学者可以从简单架构入手,比如用Keras或PyTorch搭建一个多层感知机,选择时考虑任务复杂度:简单分类用逻辑回归足矣,复杂问题如自然语言处理可能需要Transformer架构,开源框架如TensorFlow提供预训练模型(例如BERT或ResNet),你可以微调它们,节省从头开始的精力,我强调,别盲目追求最新模型——基于需求选型更高效,我在网站推荐系统中,用轻量级模型提升响应速度,确保用户体验流畅。

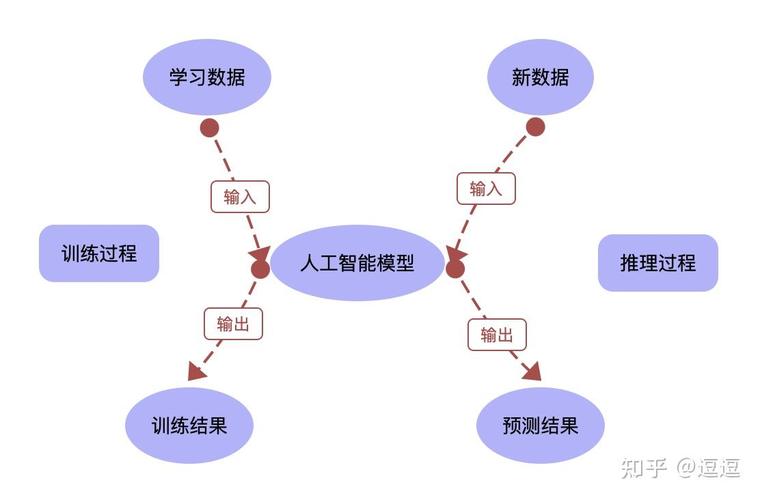

进入训练过程,这是模型“学习”的阶段,核心是优化算法,如梯度下降,它调整模型参数以最小化损失函数,你需要设置超参数:学习率控制步长大小(太高易震荡,太低收敛慢),批量大小决定每次迭代数据量,epochs指定训练轮次,使用GPU加速训练,工具如Google Colab提供免费资源,训练中监控指标很重要:损失值下降表示学习进展,准确率或F1分数衡量性能,如果损失停滞或上升,可能是过拟合信号——模型只记忆训练数据,泛化能力差,解决方案包括早停(在验证损失上升时终止)、正则化(如L2惩罚)或数据增强(添加噪声或旋转图像),我的项目里,我习惯用TensorBoard可视化训练曲线,及时调整参数,避免浪费计算资源。

评估模型是验证效果的环节,训练后,用测试集评估性能,指标如准确率、召回率或AUC-ROC,交叉验证技术能提高可靠性:多次划分数据集测试平均表现,如果结果不佳,返回检查数据或模型架构,部署前,进行A/B测试,比如在网站小范围上线模型,收集用户反馈,部署方式多样:本地服务器、云平台如AWS SageMaker,或嵌入式设备,确保模型可解释性:用SHAP或LIME工具分析决策原因,这能增强用户信任,AI训练不是一劳永逸,需持续监控和更新,我的内容过滤模型每月重新训练,适应新趋势。

训练AI模型有挑战,计算资源需求高,尤其大型模型;数据偏差导致不公平结果,如人脸识别对特定群体失效;还有环境成本问题,应对策略是:从小项目起步,用迁移学习减少数据需求;审核数据集多样性;选择高效架构降低能耗,作为站长,我重视责任——透明地解释模型局限,建立用户信赖。

AI模型训练是赋能未来的技能,通过系统步骤,任何人都能入门,关键在于动手实践:从简单任务试错,逐步深入,我相信,结合创意和严谨,AI能创造巨大价值,推动创新浪潮。