为何测试大模型至关重要

不同于传统软件“输入-输出”逻辑的确定性,大模型基于概率生成,其输出具有内在的随机性和不确定性,测试的目的,并非追求100%的正确率,而是全面评估其能力边界、风险偏好以及对特定业务的适用性,这直接关系到用户体验、数据安全以及品牌声誉,一个未经充分测试的模型,就像一位未经培训就上岗的核心员工,其表现充满了变数。

构建多维度的测试框架

一个全面的测试框架应涵盖以下几个核心维度:

能力评测:检验模型的“硬实力” 这是最基础的测试环节,旨在评估模型在各项任务上的表现。

- 基础能力: 包括语言理解与生成、知识问答、逻辑推理、多轮对话、文本摘要、代码编写等,您可以构建一个覆盖您业务场景的测试题库,观察模型的回答质量。

- 专业领域能力: 如果您的网站涉及医疗、法律、金融等垂直领域,必须测试模型在该领域的专业知识深度和准确性,医疗模型不能提供模糊或错误的健康建议。

- 复杂任务处理: 设计需要多步骤推理、信息整合或创造性思维的任务,评估模型解决复杂问题的潜力。

安全性与合规性评测:守住底线 这是评估模型风险的核心,直接关系到应用的生死存亡。

- 内容安全: 测试模型对于恶意提问、诱导性问题的抵御能力,它是否能有效拒绝生成暴力、仇恨、歧视、色情或违反法律法规的内容?

- 偏见与公平性: 检查模型在不同性别、地域、种族、文化群体相关话题上的输出,是否存在刻板印象或歧视性倾向。

- 信息可靠性: 评估模型应对“幻觉”问题的能力,即它是否倾向于编造看似合理但实际不存在的信息或数据,这对于知识类应用尤为关键。

- 数据隐私: 确保模型在交互过程中不会泄露训练数据中的敏感个人信息,并符合如《网络安全法》等相关数据保护法规。

性能与稳定性评测:保障用户体验 即便模型能力再强,若响应缓慢或时好时坏,也无法投入实际使用。

- 响应延迟: 测试模型在正常负载和高并发情况下的响应速度,确保满足用户的实时交互需求。

- 服务可用性: 进行长时间的压力测试和稳定性测试,检查服务的SLA水平。

- 长文本处理: 测试模型在处理长篇文章、大量上下文信息时的表现是否稳定。

人工评估与真实用户反馈 自动化测试虽高效,但无法完全替代人的主观判断。

- 构建评估团队: 组织内部专家或标注团队,根据预先定义的质量标准(如相关性、流畅度、有用性、安全性)对模型的输出进行打分。

- 小范围灰度发布: 在全面上线前,先向一小部分真实用户开放,收集他们的直接反馈,用户的实际使用场景和反馈往往能发现测试中无法预料的问题。

测试流程与实用工具

测试流程建议

- 第一步:明确测试目标与场景。 围绕您的业务需求,定义清楚“好”模型的标准是什么。

- 第二步:构建测试集。 收集或制作一批高质量的测试用例,应覆盖上述所有评测维度,并持续更新维护。

- 第三步:执行自动化与人工评测。 双管齐下,相互补充。

- 第四步:分析结果与迭代优化。 对测试结果进行深入分析,找出模型的薄弱环节,反馈给模型提供方或用于调整您自身的提示工程与应用策略。

可利用的基准与工具

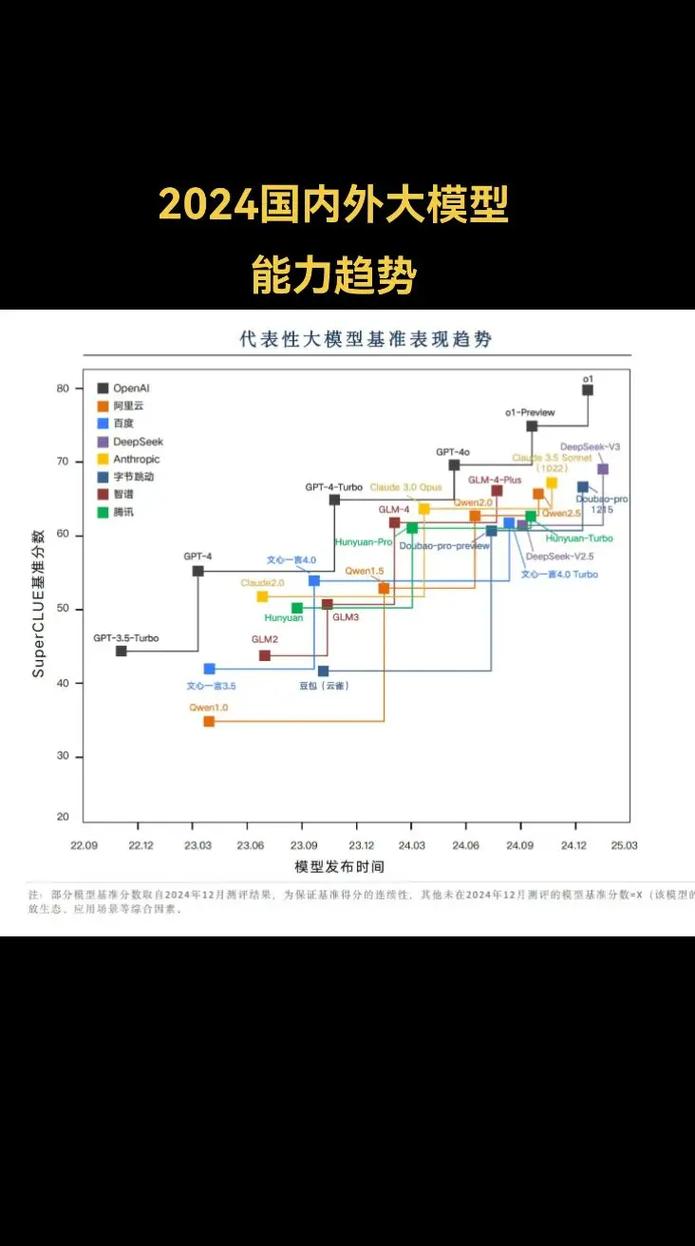

- 学术基准: 关注如MMLU、GSM8K、HumanEval等国际公认的基准测试成绩,可以作为模型基础能力的参考。

- 可视化评测平台: 一些开源或商业平台可以帮助您更直观地管理和进行模型的对战评测。

- 红队测试工具: 利用自动化工具模拟恶意攻击,系统性地探测模型的安全漏洞。

写在最后

测试AI大模型是一个持续的过程,而非一次性的项目,随着模型本身的迭代和业务需求的变化,测试体系也需要动态调整,对于站长而言,投入资源进行严谨的模型评测,不是在浪费时间,而是在为业务的稳定与长远发展铺设最坚实的地基,选择一个可靠、透明且经过您亲自验证的模型,远比盲目追求参数规模或市场热度来得重要,在这个AI技术飞速发展的时代,保持审慎的乐观和科学的评估态度,将是您驾驭这股强大力量的关键。