训练人工智能图片大模型,如Stable Diffusion或DALL-E,已成为当今科技领域的热点话题,这些模型能根据文本描述生成逼真图像,推动创意设计、医疗诊断和娱乐产业的革新,构建这样一个模型并非易事,需要深入的专业知识、海量数据和精细优化,作为从业者,我经常被问到训练过程的核心细节,今天就来分享一些关键见解,帮助大家理解背后的逻辑。

理解AI图片大模型的基础

AI图片大模型属于生成式人工智能,核心目标是学习从文本到图像的映射,它们依赖于深度学习架构,特别是扩散模型,这种模型通过逐步添加和去除噪声来生成高质量图片,训练起点是建立一个强大的基础模型,这需要大规模数据集支持,常用数据集包括LAION-5B,它集合了数十亿张网络图片和对应文本描述,数据预处理至关重要:清洗低质量图像、去除版权问题内容,并确保多样性以覆盖不同文化、场景和对象,专业团队会使用自动化工具过滤噪声,避免模型学习偏差或有害内容。

训练前,模型架构的设计是决定性因素,扩散模型分两个阶段:前向过程添加随机噪声到原始图像,反向过程则学习去噪以重建图片,这类似于教AI“逆向工程”图像生成,核心组件包括Transformer编码器处理文本输入,和U-Net结构处理图像数据,团队需优化参数数量——现代模型往往包含数十亿参数,这提升了生成能力但增加了复杂性,开源框架如PyTorch或TensorFlow是常用工具,它们提供灵活接口加速实验。

训练过程的详细步骤

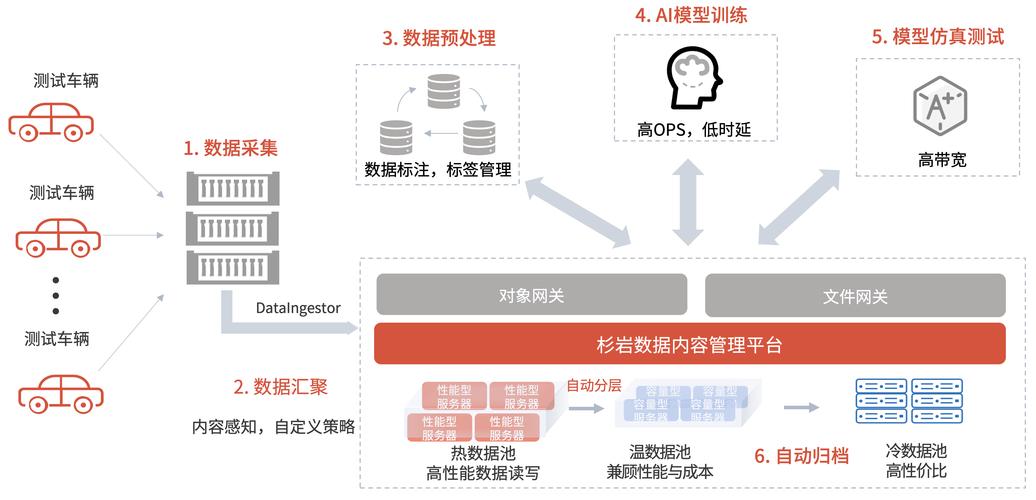

训练AI图片大模型是一个迭代旅程,分为预训练和微调阶段,整个过程依赖高性能计算资源,通常在高性能GPU集群上运行数周甚至数月,以下是关键步骤:

-

数据准备与加载:收集数十亿张高质量图像,每张都配以详细文本标注,数据必须覆盖广泛主题,如自然风景、人物肖像和抽象艺术,以确保模型泛化能力,清洗阶段移除重复、低分辨率或不当内容,使用算法检测异常值,数据被分割为训练集、验证集和测试集,验证集用于监控模型表现,测试集则评估最终性能,团队常采用分布式数据加载技术,以并行方式处理海量文件,加快训练速度。

-

模型初始化与预训练:初始阶段,模型在通用数据集上进行预训练,这涉及设置损失函数(如噪声预测损失),优化器(如AdamW)和学习率调度器,训练开始时,模型参数随机初始化,然后通过反向传播算法逐步调整,每次迭代中,输入一批次图像-文本对:模型先添加噪声,再尝试去噪重建原图,损失值衡量预测误差,指导参数更新,预训练目标是大规模学习通用模式,比如物体形状、颜色纹理和空间关系,计算资源消耗巨大——训练Stable Diffusion需数千个GPU小时,成本可达百万美元级别。

-

微调与优化:预训练后,模型进入微调阶段,针对特定任务优化,这包括领域适应(如医疗图像生成)或风格定制(如动漫风格),微调使用较小、高质量数据集,避免过拟合,技术如迁移学习和提示工程被应用:提示工程通过精炼文本输入提升生成准确性,团队进行超参数调整,如学习率和批量大小,以平衡速度和精度,安全机制也嵌入其中,比如内容过滤器防止生成暴力或侵权内容,优化工具如混合精度训练减少内存占用,而分布式训练框架(如DeepSpeed)加速并行计算。

-

评估与迭代:训练中,持续评估是保证质量的关键,指标包括FID分数(衡量生成图像真实性)和CLIP分数(评估文本-图像对齐),团队运行A/B测试,对比不同模型版本,如果表现不佳,需回溯数据或架构问题,迭代过程强调快速实验——失败案例被分析以改进算法,模型部署前通过严格测试,确保可靠性和公平性。

面临的挑战与应对策略

训练AI图片大模型伴随显著挑战,首要的是计算资源需求,高性能GPU集群必不可少,但成本高昂且能耗大,解决方案包括云服务租赁(如AWS或Google Cloud)和模型压缩技术(如知识蒸馏),以降低门槛,另一个关键问题是数据偏见:模型可能学习社会刻板印象,比如性别或种族偏差,应对策略涉及多样化数据源和公平性审计工具,例如在训练中注入平衡样本,或使用去偏算法修改损失函数。

伦理和法律风险不容忽视,生成内容可能侵犯版权或传播虚假信息,负责任训练要求团队遵循行业准则,如加入水印机制或限制生成范围,模型可解释性差是个难题——黑箱特性使调试复杂,可解释AI方法(如注意力可视化)帮助理解决策过程,持续维护是必须的:模型上线后需定期更新数据,适应新趋势。

训练这些模型代表人工智能的前沿突破,它融合了工程与创造力,个人认为,尽管过程充满技术障碍,但每一次迭代都推动着人类表达方式的进化,我们必须以谨慎态度拥抱创新,确保技术服务于社会福祉,而非加剧不平等,更高效的训练方法将 democratize 这一技术,让更多创意人受益。

(字数:约1100字)