如何训练AI变声器模型:从数据到声音的转化之旅

AI变声器的神奇魔力,能让声音在瞬间穿越性别、年龄甚至物种的界限,实现这一切的核心在于其背后的声音转换模型,训练一个优秀的模型并非易事,它是一项融合声学、机器学习和大量数据处理的系统工程,以下是构建高效AI变声器模型的关键步骤:

数据基石:高质量语音库的构建

- 来源与多样性: 训练的核心是大量成对的语音数据,理想情况是找到同一个说话人在不同场景下用不同情感、语气、语速说出的语句,录音环境需安静专业,设备达到48kHz采样率能保留更丰富的细节,数据多样性至关重要,需涵盖不同文本内容、情感表达、语速变化。

- 严格标注: 每条语音片段必须精确标注说话人身份、性别、文本内容(音素或字符级别更佳),以及可能的情感标签,清晰标注是模型理解声音特质的基础。

- 预处理净化: 原始录音需经历一系列处理:去除环境噪声、电流声;进行预加重平衡频谱;精确分割为短句或单词级别片段;音量统一化处理。

声音密码:特征提取

- 声学参数抽取: 模型不直接处理原始波形,而是分析提取关键声学特征:

- 频谱特征: 梅尔频谱倒谱系数因其模拟人耳听觉特性成为主流选择,能有效表征声音的频谱包络。

- 基频: 声音音高的核心参数,决定性别感知(男声较低,女声较高)及语调变化。

- 非周期能量: 量化声音中气声或沙哑感的成分。

- 对齐匹配: 对于基于平行数据的模型,必须确保源声音和目标声音的特征在时间轴上严格对齐,这是实现精准转换的前提。

模型架构:声音转换的核心引擎

- 序列转换模型: 主流方案采用如Tacotron 2或Transformer架构,学习从源语音特征到目标语音特征的复杂映射规律。

- 生成模型: 将转换后的特征(如梅尔频谱)还原为可听波形的关键步骤,WaveNet、WaveGlow或HiFi-GAN等声码器负责这项任务,它们能合成出高保真、自然流畅的语音。

- 端到端探索: 新兴技术如Voice Conversion Transformer尝试将特征转换与波形生成整合进单一模型,简化流程并有望提升音质。

模型训练:学习与优化的过程

- 损失函数引导: 模型通过最小化预测特征与真实目标特征之间的差异(如梅尔频谱的均方误差)来学习,感知损失函数能更好地模拟人耳听觉感受。

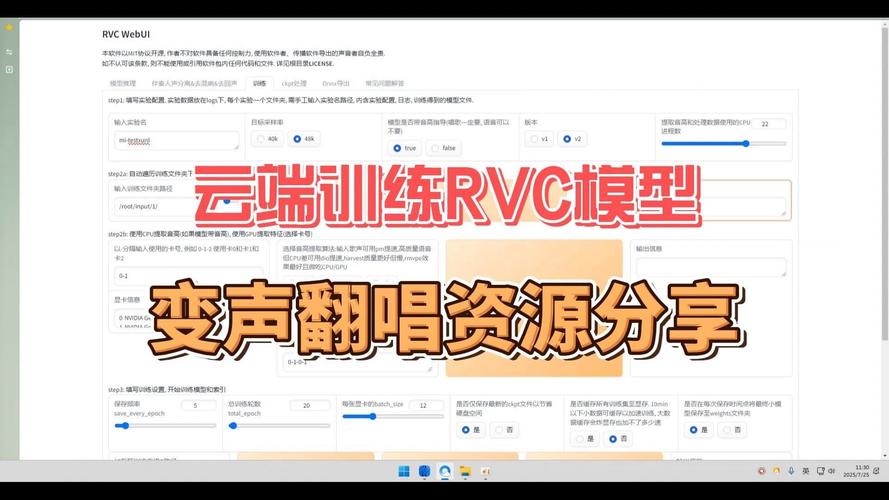

- 海量计算支撑: 训练过程需要强大的GPU算力支持,处理数十甚至数百小时的语音数据,耗时可能长达数天甚至数周。

- 关键超参数: 精心调整学习率、批次大小、网络层数及节点数等超参数,是模型达到最佳性能的必要环节,正则化技术(如Dropout)可有效防止过拟合。

优化与评估:追求自然与稳定

- 迁移学习应用: 利用在大规模通用语音数据集上预训练的模型作为起点,再进行目标声音数据的微调,能显著提升训练效率和最终效果。

- 多维度评估:

- 自然度: 主观评测(如MOS评分)至关重要,让真人听辨转换后语音是否自然流畅。

- 相似度: 判断转换后声音与目标说话人身份的接近程度。

- 清晰度: 确保语音内容清晰可懂。

- 稳定性: 避免合成声音中出现不自然的抖动、断裂或嘶哑杂音。

个人观点 训练高性能AI变声器模型远非易事,其核心挑战在于如何精准解构并重建人类声音中那些微妙而复杂的个性元素,数据质量是根基,模型设计是骨架,计算资源是动力,三者缺一不可,尤其需要警惕的是,技术应用必须严格遵循隐私保护与伦理规范,模型优化之路永无止境,追求更自然、更个性化、更可控的声音转换效果,始终是研发者不懈探索的方向。