在当今数字时代,人工智能(AI)正迅速改变我们的生活,其中文本模型扮演着核心角色,想象一下,一个AI能生成流畅的文章、回答复杂问题,甚至创作诗歌——这背后是强大的文本模型在驱动,作为网站站长,我经常探索AI技术,今天就来聊聊AI如何创建文本模型,这个过程不是魔法,而是基于科学方法一步步实现的,我会用简单语言解释关键步骤,帮助大家理解其原理和应用价值。

创建文本模型的第一步是数据收集,AI需要海量文本数据来学习语言模式,就像人类通过阅读积累知识一样,这些数据来源广泛,包括书籍、新闻文章、社交媒体帖子和网页内容,数据量越大,模型的学习能力越强,像GPT系列模型就使用了数十亿词的语料库,收集时,我们注重数据多样性,确保涵盖不同主题和语言风格,避免偏见,这个过程需要专业工具,如网络爬虫或公开数据集,但必须遵守隐私法规,数据质量直接影响模型效果,因此团队会筛选重复或低质内容,只保留高质量输入。

接下来是数据预处理,原始文本往往杂乱无章,需要清洗和格式化才能用于训练,预处理包括去除标点符号、转换大小写、分词(将句子拆分成单词或子词单元)以及处理特殊字符,英文文本可能被转换成小写形式,中文则需分词处理,这一步使用算法如正则表达式或专用库(如Python的NLTK)自动完成,目的是让数据变成结构化格式,便于模型消化,预处理还能减少噪音,提高训练效率,如果跳过这一步,模型可能学不到正确模式,输出结果会混乱不堪。

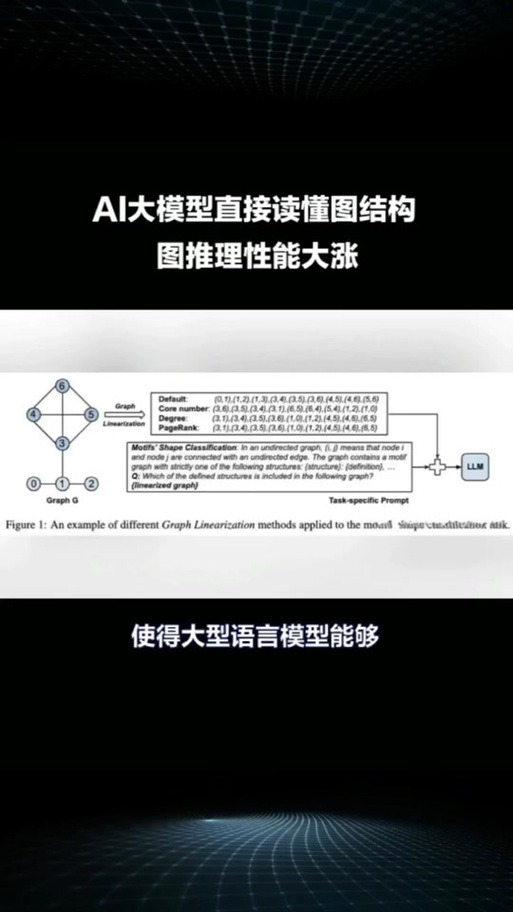

预处理完成后,就到了模型设计阶段,AI文本模型的核心是选择合适架构,目前最流行的是Transformer模型,它通过自注意力机制处理长文本序列,高效捕捉上下文关系,设计时,工程师决定模型大小,包括层数、参数数量和嵌入维度,小型模型适合移动设备,大型模型如GPT-3则用于高性能任务,这个阶段需要专业知识,团队会参考开源框架如TensorFlow或PyTorch,设计不是一蹴而就的,往往涉及多次迭代和优化,确保模型既强大又高效。

训练模型是关键环节,这里,预处理好的数据被输入到模型中,通过算法调整内部参数,训练使用监督学习或无监督学习方法,以无监督学习为例,模型预测文本序列中的下一个词,通过反向传播算法不断修正错误,训练过程依赖强大硬件,如GPU集群,处理海量计算,训练一个中型模型可能需要几天时间,消耗大量电力,期间,工程师监控指标如损失函数和准确率,防止过拟合(模型只记住数据而无法泛化),训练完成后,模型就能生成连贯文本了,但还需验证其可靠性。

评估模型是确保质量的必要步骤,训练后,AI模型需在测试数据集上评估性能,常用指标包括BLEU分数(衡量生成文本与参考文本的相似度)和困惑度(评估预测不确定性),测试场景多样,比如问答任务或文本生成实验,评估能暴露问题,如偏见或逻辑错误,团队会进行调整,如果模型在敏感话题上输出不当内容,需通过微调或添加过滤层来改进,这个过程强调透明性,让用户信任AI输出。

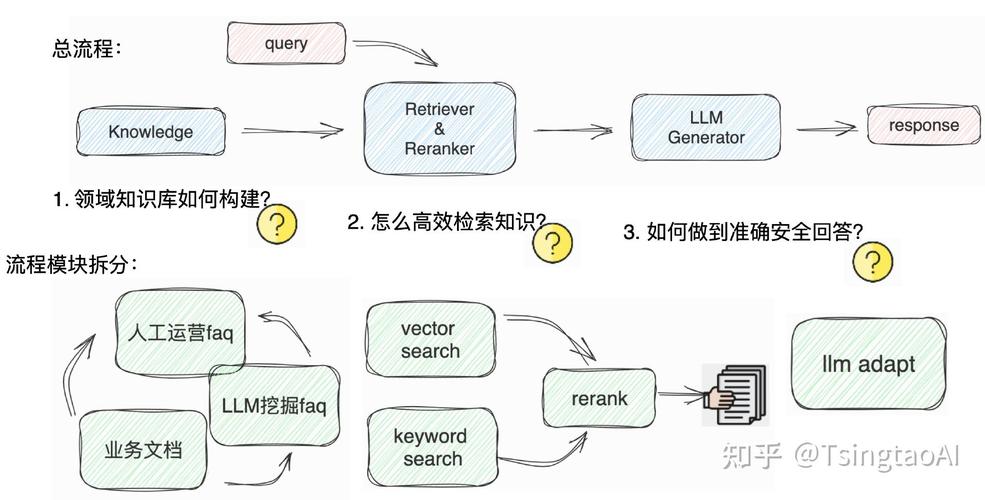

部署模型使其可用,训练好的模型被集成到应用中,如聊天机器人或内容生成工具,部署涉及压缩模型大小、优化推理速度,并确保API接口稳定,云平台如AWS或Azure简化了这一步骤,让普通开发者也能轻松使用,部署后,模型需持续监控和更新,以适应新数据,这样,AI就能实时响应用户请求,创造价值。

AI创建文本模型的过程展示了技术与创新的融合,从数据到部署,每一步都需要严谨态度和专业知识,作为实践者,我认为AI文本模型潜力巨大,能提升效率、丰富内容创作,但也需谨慎对待伦理问题,如数据隐私和公平性,随着技术进步,AI将更贴近人性,帮助我们解决更多挑战。(字数:1025)